Computex 2022:英伟达晒出CPU和GPU的最新进展

2022-05-25

13:54:01

来源: 互联网

点击

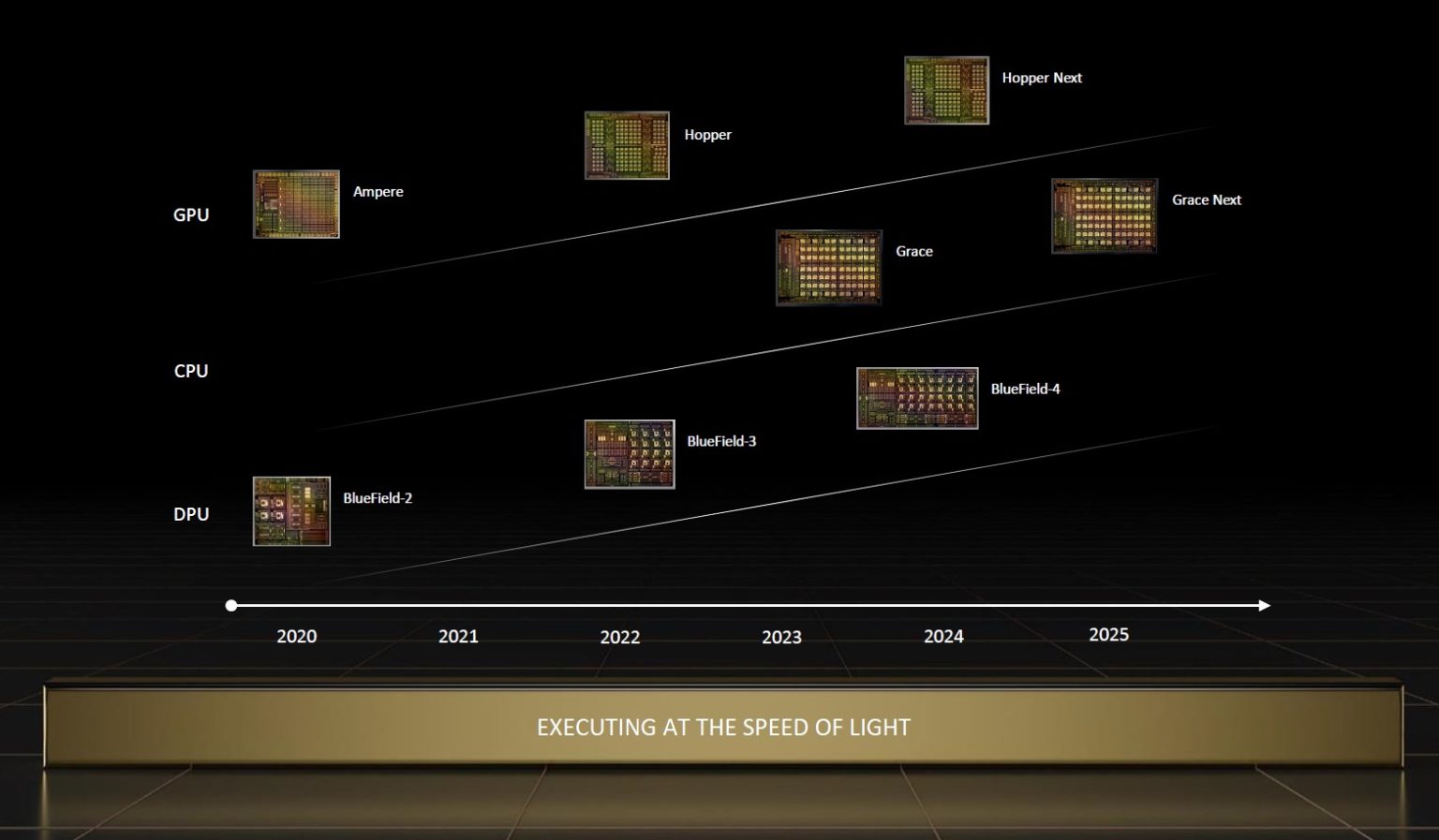

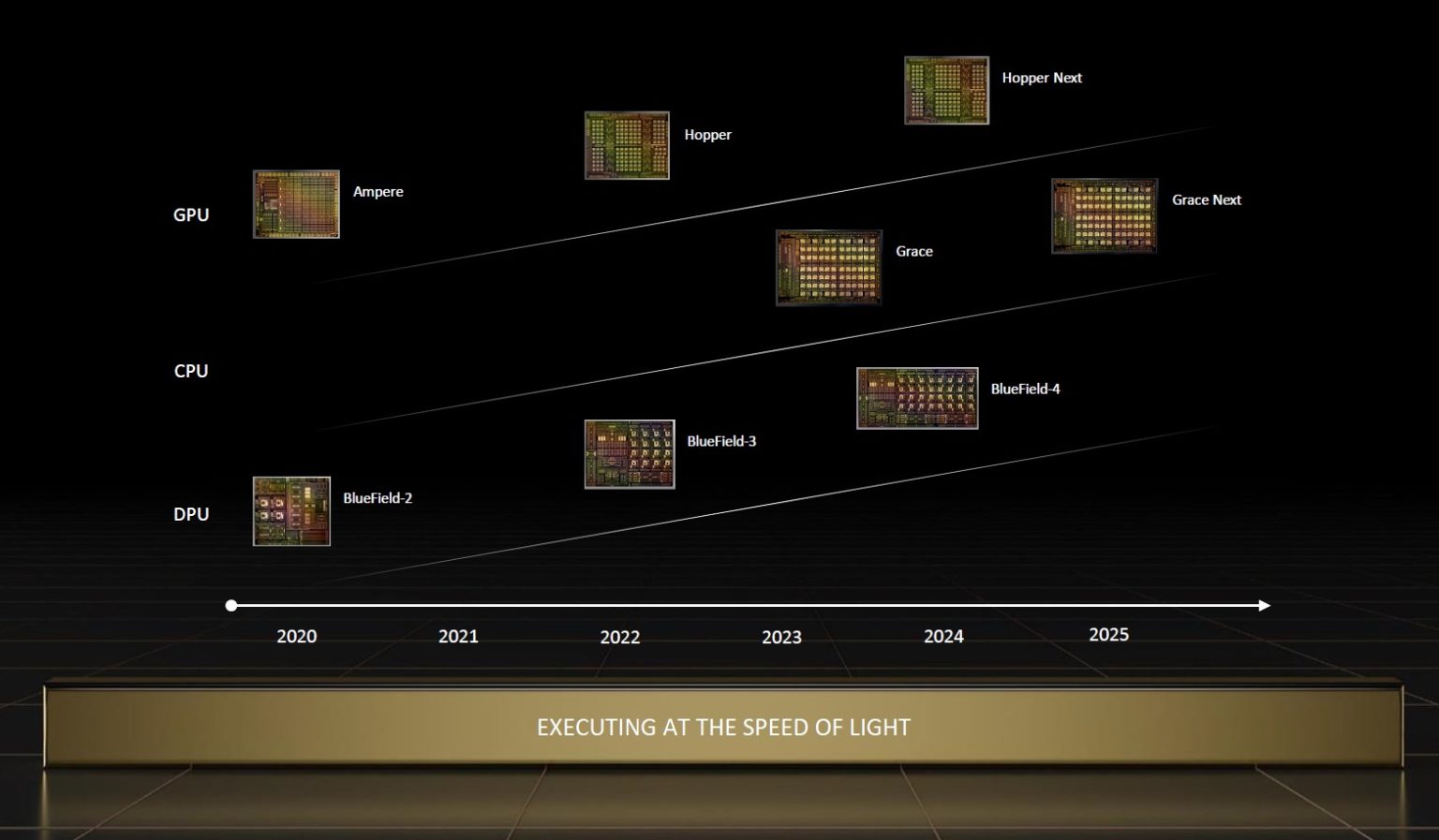

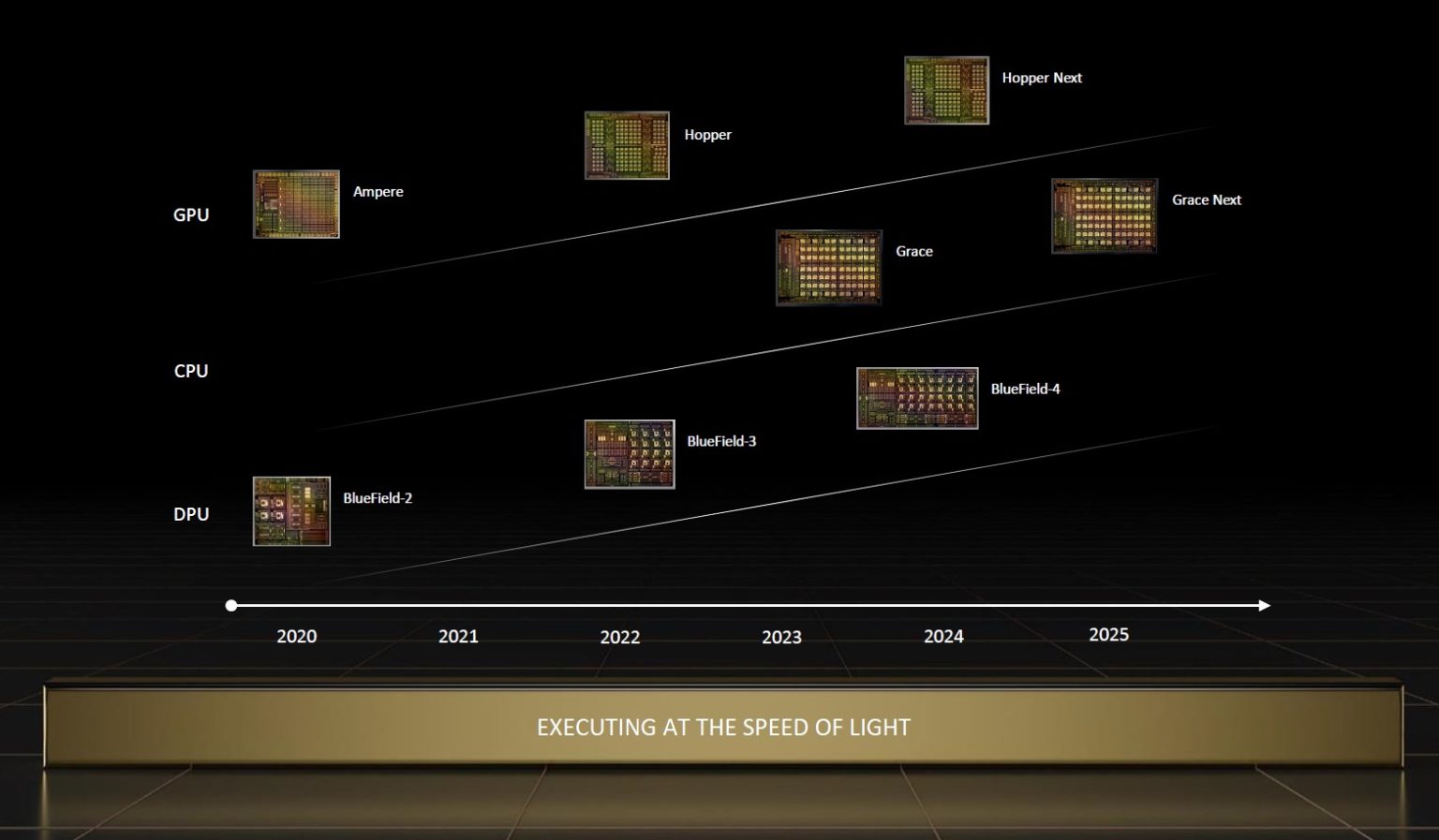

在近日的Computex 2022上,英伟达对其数据中心产品组合进行了多项更新。除了GPU和DPU之外,英伟达的CPU也加入了路线图。现在英伟达正在利用DPU和CPU来巩固GPU的地位,3U的加持将使得英伟达继续“领风骚数年”。

英伟达Grace系统迎来首批客户

从上文的路线图中我们可以看到,英伟达的Grace CPU超级芯片将与Grace-Hopper 一起于2023年推出。在此需要了解的是,英伟达的Grace CPU是基于Arm的带有LPDDR5内存的CPU。Grace-Hopper是Arm CPU加H100的组合。Grace CPU超级芯片则采用其中两个Arm CPU 并将它们放入一个模块中。

具体来看,Grace CPU超级芯片搭载两块通过NVLink®-C2C互连技术连接的CPU芯片,内置多达144个高性能Arm V9核心,并且带有可伸缩矢量扩展和每秒1 TB的内存子系统。其内存带宽和能效两倍于当今领先的服务器处理器,可满足要求最为严苛的HPC、数据分析、数字孪生、云游戏和超大规模计算应用。

Grace Hopper超级芯片是在一个集成模块中,通过NVLink-C2C将NVIDIA Hopper™ GPU与Grace CPU互联,可满足HPC和超大规模AI应用的需求。借助NVLink-C2C互连技术,Grace CPU向Hopper GPU的数据传输速度比传统CPU提升15倍。

在Computex 2022上,英伟达已经宣布,包括华硕、富士康工业互联网、技嘉科技、云达科技、超微和纬颖在内的多家领先的计算机制造商将发布首批基于 NVIDIA Grace CPU超级芯片和Grace Hopper超级芯片的系统,2U外形设计为原始设计制造商和原始设备制造商提供了蓝图和服务器底板,助力其将适用于NVIDIA CGX™云游戏、NVIDIA OVX™数字孪生、NVIDIA HGX™ AI和HPC平台的系统快速推向市场。

NVIDIA 为基于Grace的系统提供了许多参考设计,组合包括单路、双路和四路配置的单底板系统,服务器制造商可根据客户需求,为这些系统自定义四种专用于特定工作负载的设计:NVIDIA CGX系统可用于云图形和游戏,搭载Grace CPU超级芯片、BlueField-3和NVIDIA A16 GPU;NVIDIA OVX系统可用于数字孪生和协作式工作负载,搭载Grace CPU超级芯片、BlueField-3和NVIDIA GPU;NVIDIA HGX Grace系统可用于HPC和超级计算,采用纯CPU设计,搭载Grace CPU超级芯片和BlueField-3。;NVIDIA HGX Grace Hopper系统主要用于AI训练、推理和HPC,搭载Grace Hopper超级芯片和NVIDIA BlueField®-3 DPU。

除了这些新的Arm服务器之外,X86服务器仍然是英伟达销售的绝大部分。所以NVIDIA正在扩展NVIDIA认证系统™计划,以涵盖采用NVIDIA Grace CPU超级芯片和Grace Hopper超级芯片的服务器以及X86 CPU。预计首批OEM服务器认证将在合作伙伴系统出货后不久完成。

液冷GPU来了

液冷技术早期诞生于大型机时代,在当下AI 时代日臻成熟。NVIDIA GPU 在 AI 推理和高性能计算方面的能效已比 CPU 高出 20 倍,而加速计算也顺理成章地将采用液冷技术。现在NVIDIA发布了率先采用直接芯片(Direct-to-Chip)冷却技术的液冷NVIDIA A100 PCIe GPU。

旗下管理着超240个数据中心的服务提供商Equinix,致力于在业内率先实现气候中和。现在数据中心运营商旨在淘汰用于冷却数据中心内部气体的冷水机组,因其每年会蒸发数百万加仑的水量。而借助液冷技术,系统仅需对封闭系统中的少量液体进行循环利用,并能够着重于主要的发热点。

目前Equinix正在验证A100 80GB PCIe液冷GPU 其数据中心的应用,这也是该公司为实现可持续性冷却和热量捕获的综合性方案中的一部分。在单独的测试中,Equinix 和 NVIDIA 均发现:采用液冷技术的数据中心工作负载可与风冷设施持平,同时消耗的能源减少了约 30%。NVIDIA 估计,液冷数据中心的 PUE 可能达到 1.15,远低于风冷的 PUE 1.6。在空间相同的条件下,液冷数据中心可以实现双倍的计算量。这是由于 A100 GPU 仅使用一个 PCIe 插槽,而风冷 A100 GPU 需使用两个 PCIe 插槽。

“这是我们实验室中引入的首款液冷 GPU,我们倍感兴奋,因为客户迫切希望通过可持续的方式来利用 AI,”“仅仅测量功率没有意义,降低碳排放的同时提升性能才是我们努力的方向,”Equinix边缘基础设施主管Zac Smith说道。

目前英伟达的液冷GPU已进入试用阶段,预计将于今年夏季正式发布。而且至少有十几家系统制造商计划于今年晚些时候在其产品中使用液冷 GPU,包括华硕(ASUS)、永擎电子(ASRock Rack)、富士康工业互联网(Foxconn Industrial Internet)、技嘉科技(GIGABYTE)、新华三(H3C)、浪潮(Inspur)、英业达(Inventec)、宁畅(Nettrix)、云达科技(QCT)、 超微(Supermicro)、 纬颖科技(Wiwynn)和超聚变(xFusion)。

液冷技术的使用范围并不局限于数据中心,汽车和其他系统也需要利用该项技术来冷却封闭空间内的高性能系统。

遍地开花的Jetson AGX Orin

在Computex 2022上,英伟达在全球30多家领先的技术合作伙伴发布了首批基于Jetson AGX Orin的生产系统。Jetson Orin具有Ampere架构GPU、Arm Cortex-A78AE CPU、下一代深度学习和视觉加速器、高速接口、更快的内存带宽并支持能够为多个并发AI应用管道提供数据的多模态传感器。

Jetson Orin开发者套件在今年3月的GTC大会上全面上市,该套件可提供每秒275万亿次运算性能。在针脚兼容性与外形尺寸相同的情况下,其处理能力超过前代产品AGX Xavier 8倍。

通过Jetson Orin,开发者能够部署强大、复杂的模型来解决自然语言理解、3D感知、多传感器融合等领域的边缘AI和机器人挑战。

为此,在此次大会上英伟达的合作伙伴发布的Jetson产品包括服务器、边缘设备、工业PC、载板、AI软件等。这些产品将推出有风扇和无风扇配置并且提供多种连接和接口选项,还会加入适用于机器人、制造、零售、运输、智慧城市、医疗等重要经济部门或加固型应用的规格。

这些合作伙伴有来自中国台湾的研扬、凌华、研华、安提、英研智能移动、欣普罗、圆刚科技、艾讯、慧友、宸曜科技、医扬科技和超恩。其他在全球推出全新Jetson Orin解决方案的NVIDIA合作伙伴包括:Auvidea、宝视纳、Connect Tech、D3 Engineering、Diamond Systems、e-Con Systems、Framos、英飞凌、ITANZI、沥拓科技、Leopard Imaging、米文动力、Mist Elektronik、移远通信、RidgeRun、Sequitur、Silex、SmartCow、Stereolabs、Syslogic、瑞泰新时代和天准科技等。

NVIDIA嵌入式和边缘计算副总裁Deepu Talla表示:“全新Jetson AGX Orin正在大幅提升下一代机器人和边缘AI应用的性能。我们的生态系统合作伙伴相继发布基于Jetson Orin的生产系统并为特定的行业和用例定制各种外形尺寸,这将继续推动这款产品加速发展。”

英伟达Grace系统迎来首批客户

从上文的路线图中我们可以看到,英伟达的Grace CPU超级芯片将与Grace-Hopper 一起于2023年推出。在此需要了解的是,英伟达的Grace CPU是基于Arm的带有LPDDR5内存的CPU。Grace-Hopper是Arm CPU加H100的组合。Grace CPU超级芯片则采用其中两个Arm CPU 并将它们放入一个模块中。

具体来看,Grace CPU超级芯片搭载两块通过NVLink®-C2C互连技术连接的CPU芯片,内置多达144个高性能Arm V9核心,并且带有可伸缩矢量扩展和每秒1 TB的内存子系统。其内存带宽和能效两倍于当今领先的服务器处理器,可满足要求最为严苛的HPC、数据分析、数字孪生、云游戏和超大规模计算应用。

Grace Hopper超级芯片是在一个集成模块中,通过NVLink-C2C将NVIDIA Hopper™ GPU与Grace CPU互联,可满足HPC和超大规模AI应用的需求。借助NVLink-C2C互连技术,Grace CPU向Hopper GPU的数据传输速度比传统CPU提升15倍。

在Computex 2022上,英伟达已经宣布,包括华硕、富士康工业互联网、技嘉科技、云达科技、超微和纬颖在内的多家领先的计算机制造商将发布首批基于 NVIDIA Grace CPU超级芯片和Grace Hopper超级芯片的系统,2U外形设计为原始设计制造商和原始设备制造商提供了蓝图和服务器底板,助力其将适用于NVIDIA CGX™云游戏、NVIDIA OVX™数字孪生、NVIDIA HGX™ AI和HPC平台的系统快速推向市场。

NVIDIA 为基于Grace的系统提供了许多参考设计,组合包括单路、双路和四路配置的单底板系统,服务器制造商可根据客户需求,为这些系统自定义四种专用于特定工作负载的设计:NVIDIA CGX系统可用于云图形和游戏,搭载Grace CPU超级芯片、BlueField-3和NVIDIA A16 GPU;NVIDIA OVX系统可用于数字孪生和协作式工作负载,搭载Grace CPU超级芯片、BlueField-3和NVIDIA GPU;NVIDIA HGX Grace系统可用于HPC和超级计算,采用纯CPU设计,搭载Grace CPU超级芯片和BlueField-3。;NVIDIA HGX Grace Hopper系统主要用于AI训练、推理和HPC,搭载Grace Hopper超级芯片和NVIDIA BlueField®-3 DPU。

除了这些新的Arm服务器之外,X86服务器仍然是英伟达销售的绝大部分。所以NVIDIA正在扩展NVIDIA认证系统™计划,以涵盖采用NVIDIA Grace CPU超级芯片和Grace Hopper超级芯片的服务器以及X86 CPU。预计首批OEM服务器认证将在合作伙伴系统出货后不久完成。

液冷GPU来了

液冷技术早期诞生于大型机时代,在当下AI 时代日臻成熟。NVIDIA GPU 在 AI 推理和高性能计算方面的能效已比 CPU 高出 20 倍,而加速计算也顺理成章地将采用液冷技术。现在NVIDIA发布了率先采用直接芯片(Direct-to-Chip)冷却技术的液冷NVIDIA A100 PCIe GPU。

旗下管理着超240个数据中心的服务提供商Equinix,致力于在业内率先实现气候中和。现在数据中心运营商旨在淘汰用于冷却数据中心内部气体的冷水机组,因其每年会蒸发数百万加仑的水量。而借助液冷技术,系统仅需对封闭系统中的少量液体进行循环利用,并能够着重于主要的发热点。

目前Equinix正在验证A100 80GB PCIe液冷GPU 其数据中心的应用,这也是该公司为实现可持续性冷却和热量捕获的综合性方案中的一部分。在单独的测试中,Equinix 和 NVIDIA 均发现:采用液冷技术的数据中心工作负载可与风冷设施持平,同时消耗的能源减少了约 30%。NVIDIA 估计,液冷数据中心的 PUE 可能达到 1.15,远低于风冷的 PUE 1.6。在空间相同的条件下,液冷数据中心可以实现双倍的计算量。这是由于 A100 GPU 仅使用一个 PCIe 插槽,而风冷 A100 GPU 需使用两个 PCIe 插槽。

“这是我们实验室中引入的首款液冷 GPU,我们倍感兴奋,因为客户迫切希望通过可持续的方式来利用 AI,”“仅仅测量功率没有意义,降低碳排放的同时提升性能才是我们努力的方向,”Equinix边缘基础设施主管Zac Smith说道。

目前英伟达的液冷GPU已进入试用阶段,预计将于今年夏季正式发布。而且至少有十几家系统制造商计划于今年晚些时候在其产品中使用液冷 GPU,包括华硕(ASUS)、永擎电子(ASRock Rack)、富士康工业互联网(Foxconn Industrial Internet)、技嘉科技(GIGABYTE)、新华三(H3C)、浪潮(Inspur)、英业达(Inventec)、宁畅(Nettrix)、云达科技(QCT)、 超微(Supermicro)、 纬颖科技(Wiwynn)和超聚变(xFusion)。

液冷技术的使用范围并不局限于数据中心,汽车和其他系统也需要利用该项技术来冷却封闭空间内的高性能系统。

遍地开花的Jetson AGX Orin

在Computex 2022上,英伟达在全球30多家领先的技术合作伙伴发布了首批基于Jetson AGX Orin的生产系统。Jetson Orin具有Ampere架构GPU、Arm Cortex-A78AE CPU、下一代深度学习和视觉加速器、高速接口、更快的内存带宽并支持能够为多个并发AI应用管道提供数据的多模态传感器。

Jetson Orin开发者套件在今年3月的GTC大会上全面上市,该套件可提供每秒275万亿次运算性能。在针脚兼容性与外形尺寸相同的情况下,其处理能力超过前代产品AGX Xavier 8倍。

通过Jetson Orin,开发者能够部署强大、复杂的模型来解决自然语言理解、3D感知、多传感器融合等领域的边缘AI和机器人挑战。

为此,在此次大会上英伟达的合作伙伴发布的Jetson产品包括服务器、边缘设备、工业PC、载板、AI软件等。这些产品将推出有风扇和无风扇配置并且提供多种连接和接口选项,还会加入适用于机器人、制造、零售、运输、智慧城市、医疗等重要经济部门或加固型应用的规格。

这些合作伙伴有来自中国台湾的研扬、凌华、研华、安提、英研智能移动、欣普罗、圆刚科技、艾讯、慧友、宸曜科技、医扬科技和超恩。其他在全球推出全新Jetson Orin解决方案的NVIDIA合作伙伴包括:Auvidea、宝视纳、Connect Tech、D3 Engineering、Diamond Systems、e-Con Systems、Framos、英飞凌、ITANZI、沥拓科技、Leopard Imaging、米文动力、Mist Elektronik、移远通信、RidgeRun、Sequitur、Silex、SmartCow、Stereolabs、Syslogic、瑞泰新时代和天准科技等。

NVIDIA嵌入式和边缘计算副总裁Deepu Talla表示:“全新Jetson AGX Orin正在大幅提升下一代机器人和边缘AI应用的性能。我们的生态系统合作伙伴相继发布基于Jetson Orin的生产系统并为特定的行业和用例定制各种外形尺寸,这将继续推动这款产品加速发展。”

责任编辑:sophie

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻