AI性能3年提升23倍,不愧是NVDIA!

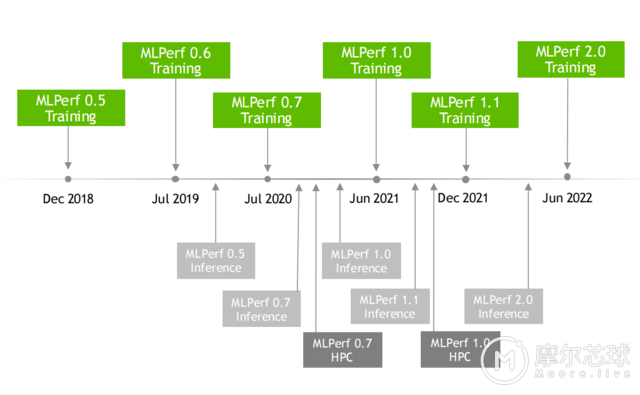

MLPerf的基准测试代表了当今最流行的AI用例,包括语音识别、自然语言处理、推荐系统、目标检测、图像分类等。NVIDIA自2018年12月开始向作为行业标准AI基准测试的MLPerf提交首轮测试结果,数次的结果显示出NVIDIA AI的性能优势,截止到目前,NVIDIA AI仍是唯一能够运行MLPerf行业基准测试中所有测试的平台。

A100是MLPerf的常胜将军

而A100 GPU更是自发布以来连续两年一直保持着获胜次数最多的纪录,如下图所示,从2020年MLPerf 0.7开始,A100就稳坐第一的位置。

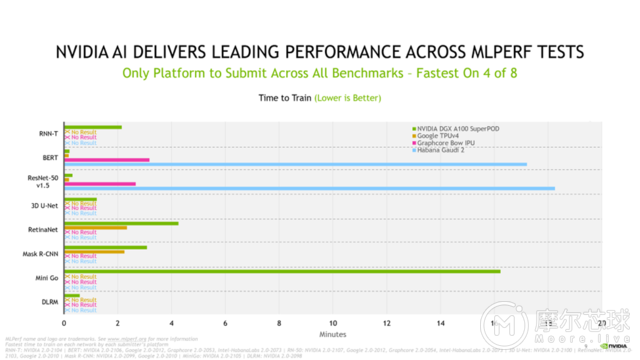

在最新的MLPerf基准测试中,采用NVIDIA A100的AI超算计算机Selene在八项大规模工作负载测试的四项中再次获得“最快训练时间”。Selene是基于模块化的NVIDIA DGX SuperPOD,并由NVIDIA A100 GPU、软件堆栈和NVIDIA InfiniBand网络驱动。NVIDIA AI 平台覆盖了MLPerf 训练2.0版本中的所有八项基准测试,突显了其领先的通用性。

各个提交者平台在每个网络的“最快训练时间”

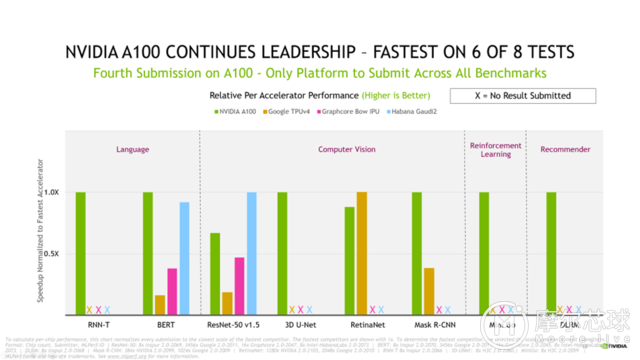

而且在单芯片性能的测试中,NVIDIA A100在八项测试中的六项测试中呈现了最快的速度。

为了计算单芯片性能,该图表将每份提交结果归一化到每个提交者最常见的尺度,检测分数归一化到速度最快的竞争者,最快竞争者显示为1倍。

本次MLPerf基准测试中,NVIDIA及其合作伙伴占了所有参赛生态伙伴的90%,包括华硕、百度、中国科学院自动化研究所、戴尔科技、富士通、技嘉、新华三、慧与、浪潮、联想、宁畅和超微在内的合作伙伴都提供了最佳的整体AI训练性能和提交了最多的测试项。这表示采用NVIDIA的服务器能够为企业部署提供出色的性能、可管理性、安全性和可扩展性。

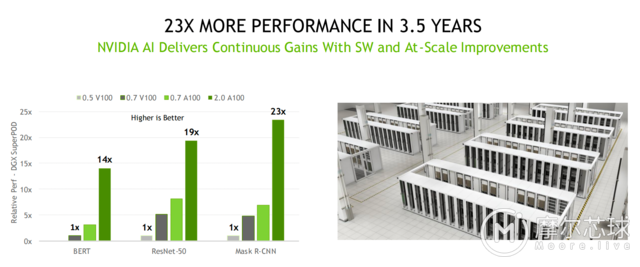

3年性能提高23倍,NVIDIA是如何做到的?

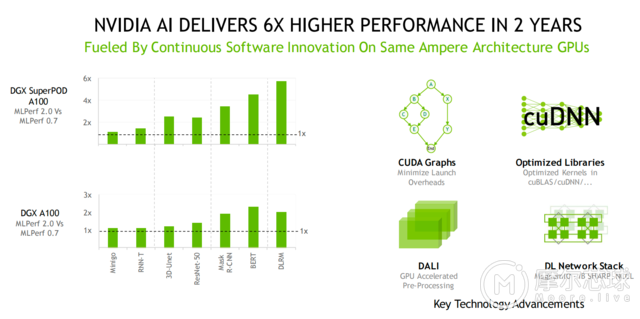

自首次基于A100提交MLPerf基准测试以来的两年时间里,NVIDIA平台的性能已提高了6倍。而这主要归功于NVIDIA软件堆栈持续优化所推动。例如,在提交结果中大量使用的CUDA Graphs,该软件可以最大限度地减少跨多个加速器上运行作业的启动开销。此外再加上NVIDIA不同库的内核优化,如cuDNN和预处理库DALI,解锁了额外的加速。

如果放眼全部的MLPerf提交历程,借由跨GPU、软件和大规模改进的全栈式创新,如NVIDIA Magnum IO和SHARP,将部分AI功能卸载到网络中,以获得更好的性能。NVIDIA AI平台在3年半时间里,在基准测试中实现了23倍的性能提升。正是这种对创新的持续追求,让客户确信他们现今投资的AI平台将持续服务3至5年,并将继续推进以适配最先进的技术。

NVIDIA 所使用的所有软件均可从MLPerf资源库中获取,所有人都可以获得NVIDIA的世界级领先成果。NVIDIA不断地将这些优化集成到NVIDIA的GPU应用软件中心——NGC上提供的容器中,并通过NVIDIA AI Enterprise提供完全由NVIDIA支持,并经过优化的软件。

更通用的AI帮助客户减少部署成本

AI的实际应用诸多,一个简单的任务就需要多种类型的AI模型来工作,而且用户还需要能够快速且灵活地设计、训练、部署和优化这些模型。所以就需要通用的、性能领先的AI模型。

对于客户而言,数据科学和工程团队是最宝贵的资源,他们的生产力决定了AI基础设施的投资回报。客户必须考虑昂贵的数据科学团队的成本,这通常在部署AI的总成本中占比很重,而部署AI基础设施本身的成本相对较少。

AI研究人员的生产力取决于能否快速测试新的想法,这需要通用性来训练任何模型,以及大规模训练模型所能提供的速度。这就是为什么企业关注单位成本的整体生产力,以确定最佳的AI平台——更全面的视角,更准确地代表了部署AI的真实成本。

此外,AI基础设施的利用率取决于可替换性,或在单一平台上加速从数据准备到训练再到推理的整个AI工作流程的能力。

凭借NVIDIA AI,客户可以在整个AI流程中使用相同的基础设施,重新利用它来适配数据准备、训练和推理之间的不同需求,这极大地提高了利用率,实现了非常高的投资回报率。

随着研究人员发现新的AI突破口,支持最新模型创新是最大程度地延长AI基础设施使用寿命的关键。

NVIDIA AI兼容并适用于每个模型、可以扩展到任何规模,并加速从数据准备到训练再到推理的端到端AI流程,能够实现最高的单位成本生产力。

结语

今天的结果再次证明了NVIDIA在迄今为止所有MLPerf训练、推理和HPC评测中所展示的丰富而深厚的AI专业性。NVIDIA平台可以在所有云端和主要的服务器制造商上使用,适用于任何规模的模型和框架,并具有可替代性以处理AI工作负载的每个部分。值得一提的是,NVIDIA的下一代Hopper架构有望在未来的MLPerf评测中实现另一巨大飞跃。

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻