最新MLPerf结果:NVIDIA H100 GPU一骑绝尘

2022-09-09

11:49:19

来源: 互联网

点击

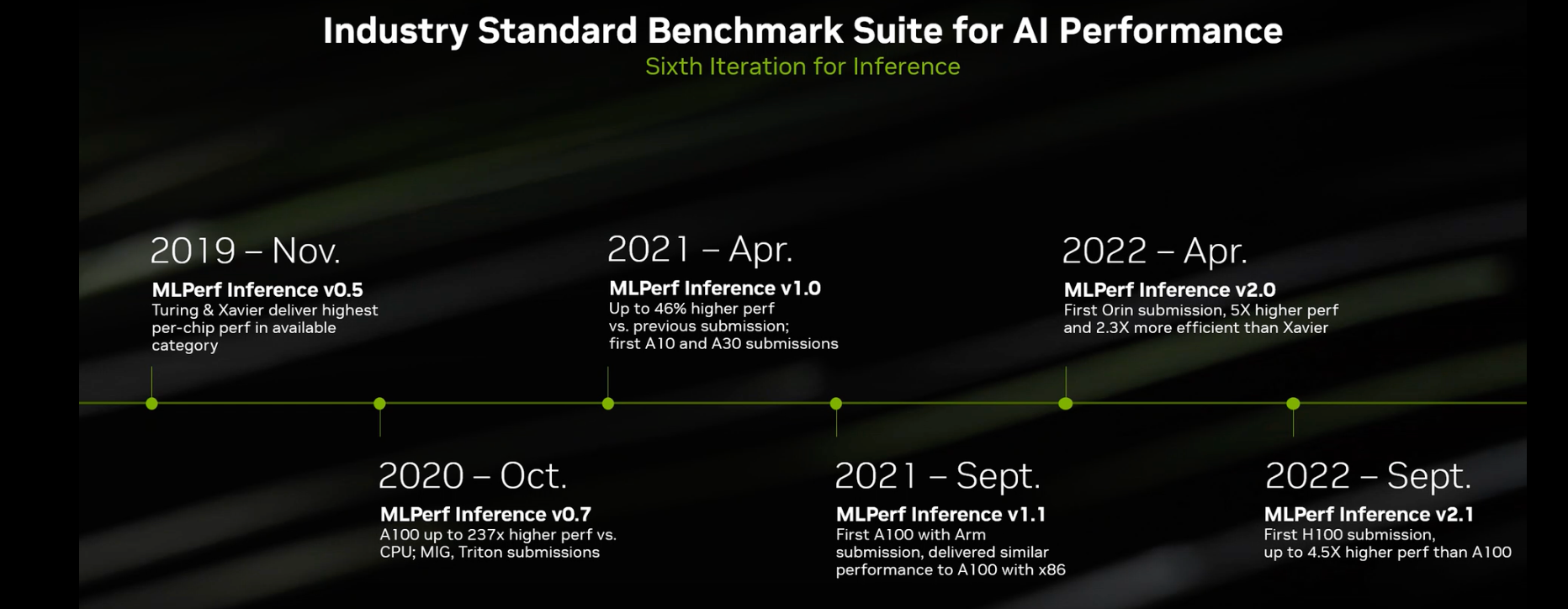

从2019年开始,在行业标准AI推理测试MLPerf的历年榜单上,NVIDIA是常客。目前,NVIDIA AI是唯一能够在数据中心和边缘计算中运行所有MLPerf推理工作负载和场景的平台。近日,NVIDIA H100 GPU首次亮相MLPerf,在所有工作负载推理中均创造了世界纪录,其性能比上一代GPU高出4.5倍。

NVIDIA参与MLPerf的历程

H100在数据中心所有负载中树立新标杆

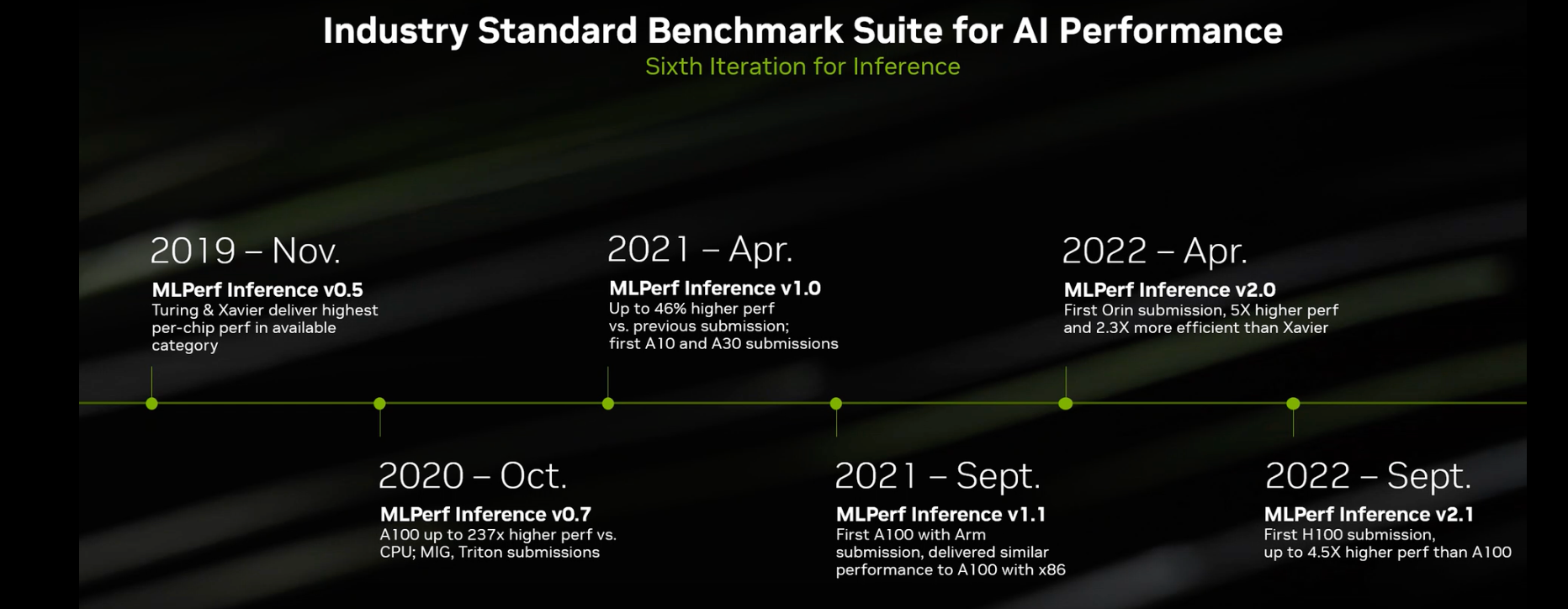

在最新的MLPerf测试结果中,H100(又名Hopper)的单加速器性能,在所有六个神经网络中取得了最优的成绩,它在单个服务器和离线场景中展现出吞吐量和速度方面的领先优势。H100为数据中心类别的所有工作负载上都树立了新标杆。

而与自身相比,NVIDIA Hopper架构的性能比NVIDIA Ampere架构高出4.5倍,不过Ampere架构GPU在MLPerf结果中继续保持全方位领先地位。

在这些典型的AI训练模型中,BERT是MLPerf AI模型中规模最大、对性能要求最高的的模型之一。Hopper在BERT模型上表现出色的原因,部分归功于其Transformer Engine。

这些测试结果表明,对于那些需要在高级AI模型上获得最高性能的用户来说,Hopper将是最优选择。

A100继续展现领先优势

除了H100 GPU之外,NVIDIA 的A100 GPU继续在主流AI推理性能方面展现出全方位领先。在数据中心和边缘计算类别与场景中,A100 GPU赢得的测试项超过了任何其他提交的结果。

自2020年7月在MLPerf上首次亮相以来由于NVIDIA AI软件的不断改进,A100 GPU的性能已经提升了6倍。早在6月的MLPerf训练基准测试中A100就取得了全方位的领先,NVIDIA A100 还继续保持其单芯片领先地位,在八项测试中的六项测试中证明是最快的。

NVIDIA A100 Tensor Core GPU和用于AI机器人的NVIDIA Jetson AGX Orin模块在所有MLPerf测试中继续表现出整体领先的推理性能,包括图像和语音识别自然语言处理和推荐系统。

目前主要的云服务商和系统制造商均在使用A100 GPU。

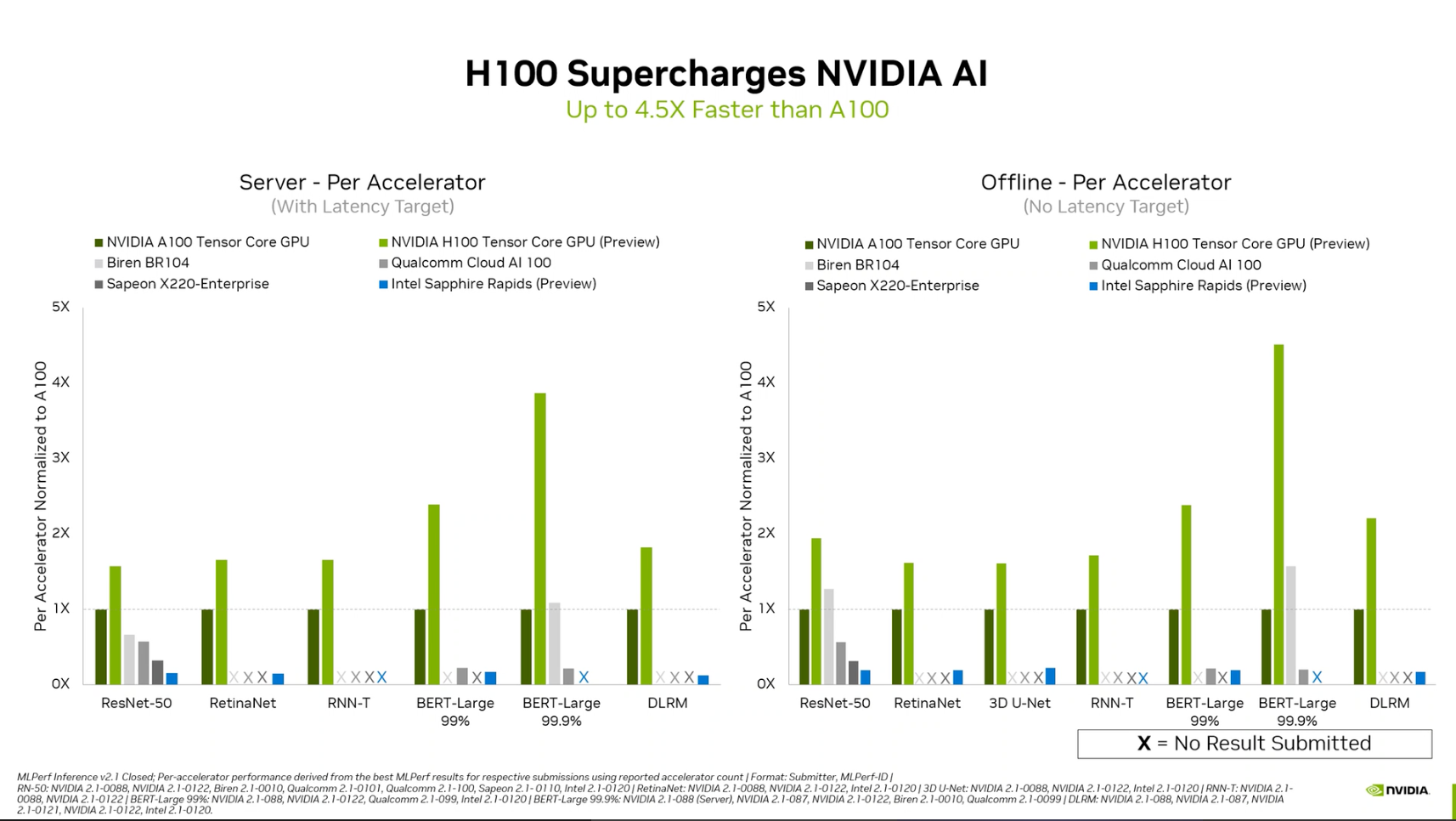

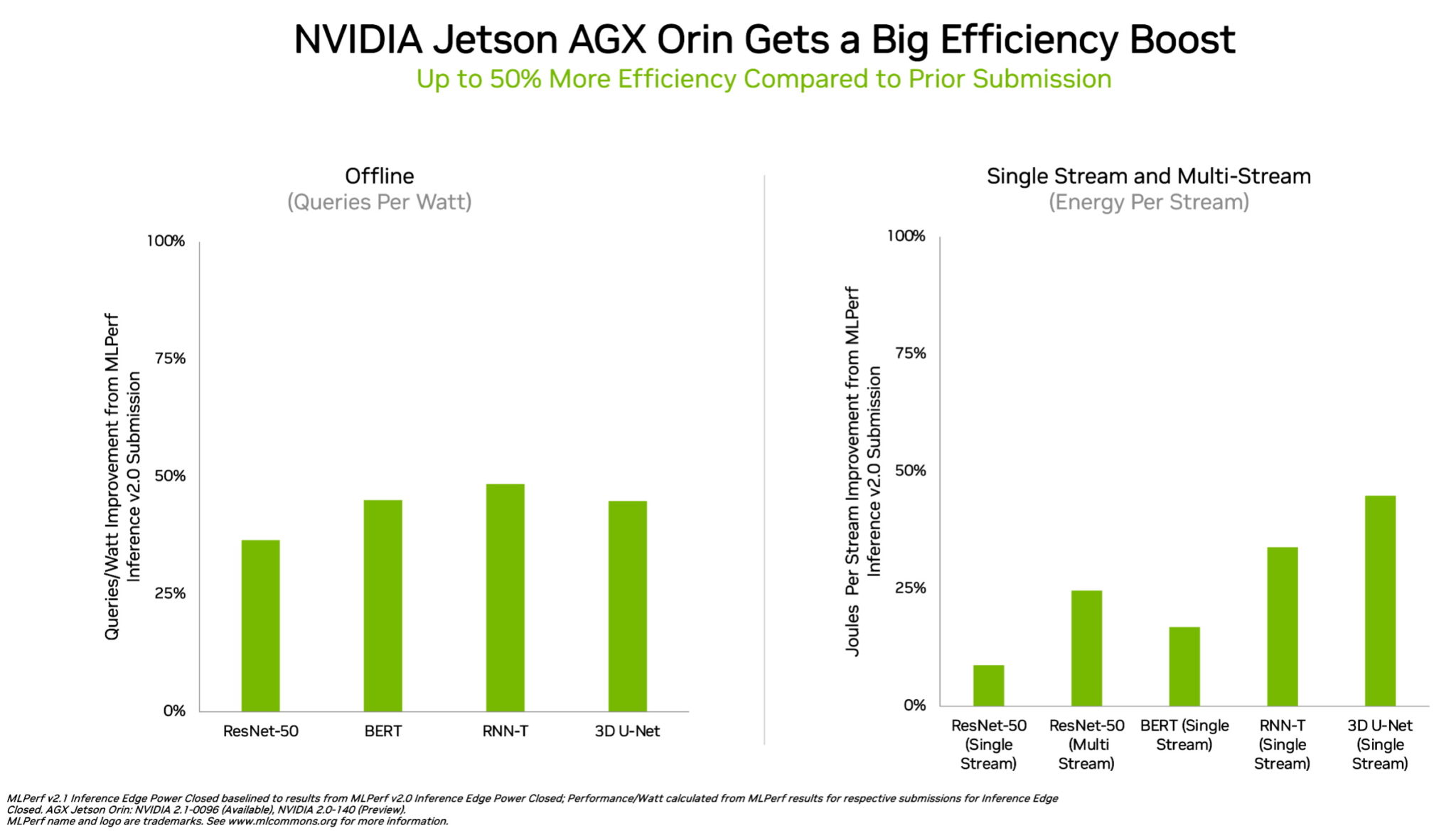

Orin是低功耗芯片测试中赢家

在边缘计算方面,NVIDIA Orin运行了所有MLPerf基准测试,是所有低功耗系统级芯片(SOC)中赢得测试最多的芯片。并且,与4月在MLPerf上的首次亮相相比,其能效提高了50%。

在上一轮基准测试中,Orin的运行速度和平均能效分别比上一代Jetson AGX Xavier模块高出5倍和2倍。

Orin将NVIDIA Ampere架构GPU和强大的Arm CPU内核集成到一块芯片中。Orin现已被用在NVIDIA Jetson AGX Orin开发者套件以及机器人和自主系统生产模块,并支持完整的 NVIDIA AI 软件堆栈,,包括自动驾驶汽车平台(NVIDIA Hyperion)、医疗设备平台(Clara Holoscan)和机器人平台(Isaac)。

MLPerf成为AI应用的“试金石”

用户在实际应用中通常会采用许多不同类型的神经网络。例如,一个AI应用可能需要理解用户的语音请求、对图像进行分类、提出建议,然后以人声作为语音信息提供回应。每个步骤都需要用到不同类型的AI模型。因此,用户需要具有通用性能的GPU芯片来处理。

MLPerf基准测试涵盖了所有这些和其他流行的AI工作负载与场景,比如计算机视觉、自然语言处理、推荐系统、语音识别等。这些测试确保用户将获得可靠且部署灵活的性能。

历年的MLPerf测试结果显示,NVIDIA AI得到了业界最广泛的机器学习生态系统的支持。在这一轮基准测试中,有超过70项提交结果在NVIDIA平台上运行。例如,Microsoft Azure提交了在其云服务上运行NVIDIA AI的结果。此外,10家系统制造商的19个NVIDIA认证系统参加了本轮基准测试,包括华硕、戴尔科技、富士通、技嘉、慧与、联想、和超微等。它们的结果表明,无论是在云端还是在自己数据中心运行的服务器中,用户都可以借助NVIDIA AI获得出色的性能。

MLPerf凭借其透明性和客观性使用户能够做出明智的购买决定。该基准测试得到了包括亚马逊、Arm、百度、谷歌、哈佛大学、英特尔、Meta、微软、斯坦福大学和多伦多大学在内的广泛支持。NVIDIA的合作伙伴参与MLPerf是因为他们知道这是一个为客户评估AI平台和厂商的重要工具。最新一轮结果表明,他们目前向用户提供的性能将随着NVIDIA平台的发展而增长。

用于这些测试的所有软件都可以从MLPerf库中获得,因此任何人都可以获得这些世界级成果。NGC(NVIDIA的GPU加速软件目录)上正在源源不断地增加以容器化形式提供的优化。还有NVIDIA TensorRT,本轮测试的每此提交都使用它来优化AI推断。

责任编辑:sophie

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻