NVIDIA与VMware强强联合,加速生成式AI的到来

2023-08-23

15:34:01

来源: 互联网

点击

2023年最火的行业,生成式AI说第二,没有人敢说第一。据麦肯锡的预测显示,生成式 AI 每年可能为全球经济带来高达 4.4 万亿美元的增长。这也让越来越多的企业愈发看重生成式AI的开发和应用,希望它们能为业务带来更快的回报。

在近期的VMware Explore 2023大会上,VMware与NVIDIA宣布进一步加强合作,全新 VMware Private AI Foundation With NVIDIA帮助企业迎接生成式AI在业务中的应用浪潮。

NVIDIA 创始人兼首席执行官黄仁勋表示:“世界各地的企业都在竞相将生成式 AI 整合到自身业务中。通过与 VMware 扩大合作,我们将能够为金融服务、医疗、制造等领域的数十万家客户提供其所需的全栈式软件和计算,使其能够使用基于自身数据定制的应用,充分挖掘生成式 AI 的潜力。”

VMware Private AI Foundation with NVIDIA

VMware Private AI Foundation with NVIDIA平台采用的NVIDIA NeMo是 NVIDIA AI Enterprise(NVIDIA AI 平台的操作系统)中包含的端到端云原生框架,它集自定义框架、护栏工具包、数据整理工具和预训练模型于一身,使企业能够以一种简单、经济且快速的方式来采用生成式AI。

为了将生成式 AI 部署到生产中,NeMo使用 TensorRT for Large Language Models(TRT-LLM),以加速并优化 NVIDIA GPU 上最新 LLM 的推理性能。通过 NeMo,VMware Private AI Foundation with NVIDIA 将使企业能够导入自己的数据,并在 VMware 混合云基础架构上构建和运行自定义生成式 AI 模型。

VMware Private AI Foundation with NVIDIA将使企业能够自定义模型并运行各种生成式AI 应用,如智能聊天机器人、助手、搜索和摘要等。该平台将作为全集成式解决方案,采用 NVIDIA 提供的生成式 AI 软件和加速计算,基于 VMware Cloud Foundation 构建,并针对 AI 进行了优化。

VMware Private AI Foundation with NVIDIA 将助力企业充分利用这一能力,以定制大语言模型,创建供内部使用的更加安全的私有模型,将生成式 AI 作为一项服务提供给用户,并更加安全地大规模运行推理工作负载。

VMware首席执行官 Raghu Raghuram 表示:“生成式 AI 与多云可谓珠联璧合。客户的数据无处不在,遍布其数据中心、边缘、云等多处。我们将与 NVIDIA 一同助力企业放心地在数据附近运行生成式 AI 工作负载,并解决其在企业数据隐私、安全和控制方面的问题。”

八大优势提升生成式 AI 的性能

该平台计划提供的各种集成式AI工具,将帮助企业经济高效地运行使用其私有数据训练而成的成熟模型。这一建立在VMware Cloud Foundation 和 NVIDIA AI Enterprise 软件上的平台预计能够提供以下方面的优势:

隐私:将通过能够保护数据隐私并确保访问安全的架构,使客户能够在任何数据所在地轻松运行 AI 服务。

选择:从 NVIDIA NeMo 到 Llama 2 等,企业在构建和运行其模型的位置上,将拥有广泛的选择空间,包括领先的 OEM 硬件配置以及未来的公有云和服务提供商解决方案。

性能:近期的行业基准测试表明,某些用例在 NVIDIA 加速基础设施上运行的性能与裸机性能相当,甚至超过了裸机性能。

数据中心规模:虚拟化环境中的 GPU 扩展优化使 AI 工作负载能够在单个虚拟机和多个节点上扩展到最多 16 颗 vGPU/GPU,从而加快生成式 AI 模型的微调和部署速度。

更低的成本:将最大程度地利用 GPU、DPU 和 CPU 的所有计算资源以降低总体成本,并创建可在各个团队间高效共享的池化资源环境。

加速存储:VMware vSAN Express Storage Architecture 提供性能经过优化的 NVMe 存储,并支持通过 RDMA 实现 GPUDirect® 存储,从而无需 CPU 即可实现从存储到 GPU 的直接 I/O 传输。

加速网络:vSphere 与 NVIDIA NVSwitch™ 技术之间的深度集成将进一步确保多 GPU 模型的执行不会出现 GPU 间瓶颈问题。

快速部署和价值实现时间:vSphere Deep Learning VM 镜像和镜像库将提供稳定的统包解决方案镜像,该镜像预先安装了各种框架和性能经过优化的库,可实现快速原型开发。

三大服务器厂商为其打call

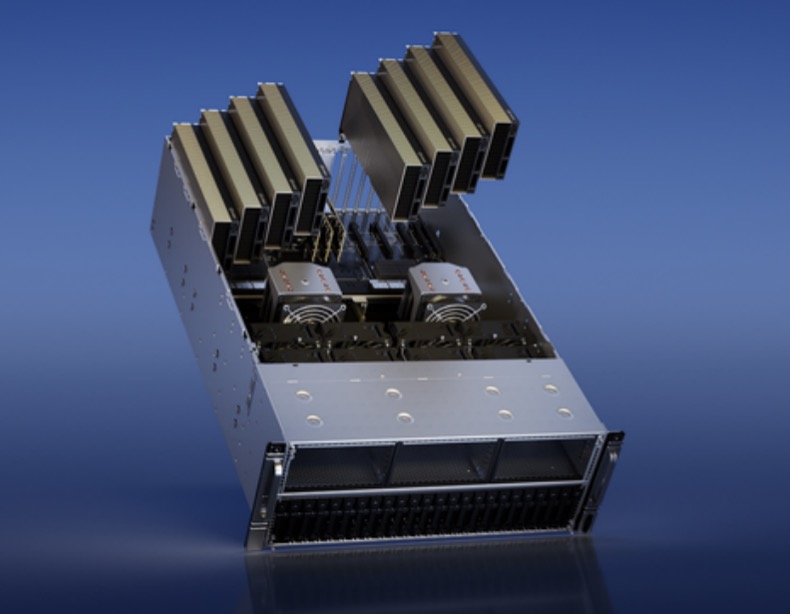

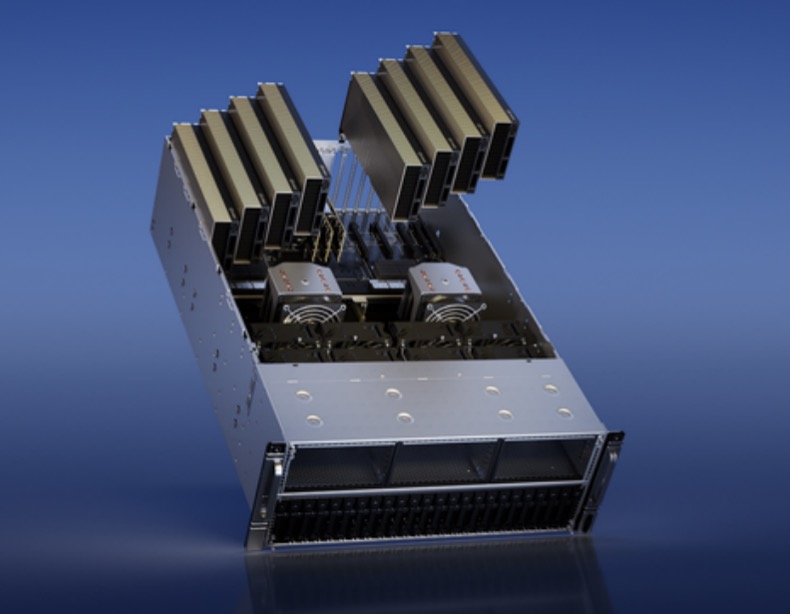

全球领先的计算机制造商戴尔科技、慧与和联想正在构建 NVIDIA AI 就绪型服务器,包括戴尔 PowerEdge R760xa、适用于VMware Private AI Foundation with NVIDIA 的慧与ProLiant Gen11 服务器以及联想ThinkSystem SR675 V3。

这些服务器将采用NVIDIA L40S GPU、NVIDIA BlueField-3 DPU 和 NVIDIA AI Enterprise 软件使企业能够微调生成式 AI 基础模型并部署生成式 AI 应用,比如智能聊天机器人、搜索和摘要工具等。这些服务器还提供由NVIDIA 加速的基础设施和软件,以支持 VMware Private AI Foundation with NVIDIA。

其中,专为处理包含数十亿参数的复杂 AI 工作负载而打造的 L40S GPU 搭载第四代 Tensor Core 和 FP8 Transformer 引擎,可提供超 1.45 PFLOPS 的张量处理能力,其训练性能是 NVIDIA A100 Tensor Core GPU 的 1.7 倍。相较于 NVIDIA A100 GPU,NVIDIA L40S 可将智能聊天机器人、助手、搜索和摘要等生成式 AI 应用中的生成式 AI 推理性能提高 1.2 倍。

值得一提的是,除了GPU之外,NVIDIA的DPU也发挥着重要的作用。通过集成 NVIDIA BlueField DPU,可加速、卸载和隔离巨大计算工作负载,其中包含虚拟化、网络、存储、安全,以及其他云原生 AI 服务,以进一步提高速度。NVIDIA ConnectX®-7 智能网卡提供先进的硬件卸载和超低延迟,可为数据密集型生成式 AI 工作负载提供同类领先的可扩展性能。

在软件方面,NVIDIA AI Enterprise,即NVIDIA AI平台的操作系统。该软件为100 多个框架、预训练模型、工具套件和软件提供生产就绪型企业级支持和安全性,包括用于 LLM 的 NVIDIA NeMo、用于模拟的 NVIDIA Modulus、用于数据科学的 NVIDIA RAPIDS 和用于生产型 AI 的 NVIDIA Triton推理服务器。

对于将部署VMware Private AI Foundation with NVIDIA 的企业来说,NVIDIA AI 就绪型服务器是一个理想的平台。

搭载 L40S GPU 和 BlueField DPU的NVIDIA AI 就绪型服务器将于年底前上市,云服务提供商预计将在未来几个月提供实例。

结语

在企业加速部署生成式AI的今天,全新VMware Private AI Foundation With NVIDIA 将帮助企业为生成式AI在业务中的应用做好准备。NVIDIA和VMware 的这一合作无疑为生成式AI的腾飞贡献了坚实的一步。

责任编辑:sophie

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻

最新新闻

热门文章 本日 七天 本月

- 1 世界飞行高度最高的平流层滑翔机,改写气象观测史

- 2 Mentor线上讲堂 | 如何使用 HLS 来优化 AI/ML、视觉和智能 IoT 应用的性能和功耗/能耗

- 3 收藏,半导体一些术语的中英文对照

- 4 一文看懂高速发展的2.5D/3D封装