发布独立AI芯片,高通再对云端市场发起冲击

上周,高通在Qualcomm AI Day活动上,公布了其专用AI芯片Cloud AI 100的开发日程,目前预定于2020年正式投入商用。高通作为移动时代的芯片业领军人物,在人工智能时代的动作确实慢了一拍,本文将分析Cloud AI 100芯片对于高通的机会和挑战,以及在系统厂商造芯越来越多的今天传统通用型芯片公司遇到的困境。

Cloud AI 100剑指云端市场

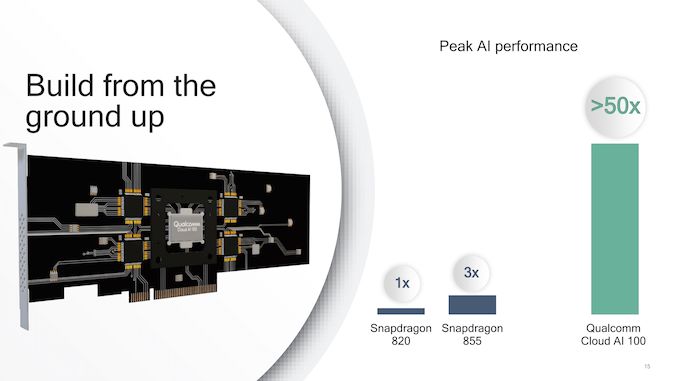

在高通的官方发布会上,宣布了对于Cloud AI 100的重要信息。首先,该芯片是一块专用于云端推理市场的ASIC专用加速器。该定位类似Google的第一代TPU,也和Nvidia对于T4的定位接近,即在云端专门执行训练好的模型计算,而非用来训练模型。根据高通的数据,Cloud AI 100的峰值算力将达到Snapdragon 820的50倍以上,可达100TOPS以上。其次,Cloud AI 100将使用TSMC 7nm HPC工艺,这意味着该芯片将直接面向高端市场。

高通投入这一块云端推理专用ASIC芯片,主要目的也是不希望错过大数据和人工智能时代的机会。我们都知道,高通时移动通信时代(大约1995-2015的二十年)的绝对霸主,但是当我们的科技进入大数据和人工智能时代时,高通看上去却是缺席了。在移动端遭遇苹果专利战以及华为技术赶超的今天,高通也急需找到其他市场的战略立足点以避免过于依赖移动市场带来的风险,因此高通布局人工智能市场也是情理之中。

我们知道,大数据和人工智能的计算一般发生在两个地方,一个是云端服务器端,另一个是在终端。在云端,终端设备会将数据汇集于此,供数据挖掘算法做训练,同时大量部署在云端的人工智能算法也在一刻不停地执行着各种任务,包括安防人脸识别、电商推荐系统、账户异常行为检测等等。高通对于云端大数据和人工智能市场并不陌生:在Cloud AI 100之前,高通的Centriq系列ARM服务器芯片就是其在云端服务器市场的一次试水,不过在经过数年努力之后,该产品被高通战略性放弃了。但是,放弃Centriq并不意味着高通放弃了云端市场,于是我们看到了Cloud AI 100。

那么为什么高通选择了云端推理市场而非训练市场呢?我们知道,现在云端的人工智能训练市场被Nvidia的GPU牢牢把控着,一方面GPU的性能对于训练来说并不成为痛点,另一方面Nvidia的CUDA生态环境非常强大。与之相对,云端人工智能推理芯片市场的形态还未尘埃落定。在今天的云端人工智能推理芯片市场,Nvidia的T系列还没有成为绝对的统治者,Habana等新兴初创公司正在向Nvidia发起冲击,这是因为Nvidia的GPU架构并非天生适合云端推理,GPU解决方案在能效比和延迟等指标上都存在提高的空间。

因此,高通选择了市场还存在较大机会的云端人工智能推理市场,而非已经难以挤入的训练市场。另外,高通明确表示Cloud AI 100面向的是中小型数据中心以及边缘计算,因此芯片的首要优化目标并非强大的算力而是能效比,而这个偏边缘计算的市场更是一个新兴的蓝海市场。根据高通的预估数据,到2025年,云端人工智能推理市场将达到170亿美元,而高通则希望在这170亿美元的蛋糕中切下一块。

高通进入服务器市场的挑战

高通在云端推理市场的挑战首先来自于已经占据先发优势的其他玩家,包括Nvidia。于2018年发布的Nvidia T4的峰值算力可达130TOPS,功耗则在70W左右,相比之下高通在2020年发布的Cloud AI 100峰值算力仅为100TOPS数量级,我们可以合理预期该算力相对Nvidia在2020年发布的下一代T系列推理GPU并不占很大优势。一般来说,即使对于边缘计算,75W也是一个可以接受的功耗数字,因此高通的Cloud AI 100必须拥有非常强的能效比优势才能说服客户选用。

Nvidia T4的性能已经超过100TOPS,将对高通的Cloud AI 100带来强烈的挑战

除了性能之外,来自Nvidia更大的挑战是生态。CUDA是目前人工智能领域的主流编程生态,其他想要挑战Nvidia的厂商都必须要越过CUDA所设下的生态壁垒。除非芯片性能远超Nvidia同类GPU且生态足够好用,否则很难说服用户放弃已经熟悉的Nvidia生态。在发布会上,高通宣布其Cloud AI 100会提供丰富的软件支持,包括完整的编译环境,以及对ONNX、TensorFlow、PyTorch、Peddle Peddle等人工智能底层框架的支持,当然这样的支持是否够好还需要届时用户试用了才能知道。

除了Nvidia之外,高通的云端推理市场最大的竞争对手其实来自于其客户,也即云服务商。虽然高通明确表示目标应用场景并非大型数据中心而是小型服务器以及边缘计算,但是事实上目前对于边缘计算布局最多的仍然是微软、亚马逊、谷歌等云服务提供商。这些云服务提供商在人工智能加速的应用上也希望能找到Nvidia之外的其他供货商,避免被Nvidia一家垄断。

看上去高通对于这些云服务商将是一个非常好的备选供货商有机会能蚕食Nvidia的市场份额,但是这些云服务商本身自己也有研发芯片的计划,这就给了高通很大的竞争压力。例如,谷歌有TPU系列人工智能加速芯片,亚马逊有Inferentia,微软有BrainWave,中国的云服务提供商如阿里巴巴和百度也都有自研人工智能加速芯片的计划。除此之外,边缘计算服务器的系统集成商也有自研芯片的动作,例如华为的边缘计算芯片Ascend系列已经在华为的服务器中开始部署。因此,高通在进军服务器市场的过程中面临着来自客户的竞争压力。

谷歌的TPU芯片已经投入实用,云提供商自研芯片将是高通的竞争对手

在这种情况下,云服务提供商(高通AI芯片的潜在客户)实际上即是运动员又是裁判员。可想而知,每个公司自己对于自己的需求是最熟悉的,因此自研的芯片对于自己的需求能最好地解决。这对于高通来说,意味着必须在技术上远超客户的自研芯片,才能获得稳定的订单,否则对于云服务提供商来说,高通可能只是排在自研芯片和Nvidia GPU后面的第三顺位供货商。

系统厂商开始造芯的时候,传统通用芯片公司遇到了挑战

高通在云市场遇到云服务商自研芯片的挑战并非孤例。事实上,随着芯片技术进入异构计算时代,平台型通用芯片在性能上往往已经无法满足系统的需求,因此越来越多的系统公司开始自研芯片,这对于传统的通用型平台芯片的商业模型将是一个很大的挑战。

随着摩尔定律发展走到了瓶颈,靠工艺取胜的思路已经不再奏效,芯片的性能提升要依靠结合特定应用的专用优化,即异构计算。这就意味着,首先对于通用芯片厂商,其针对一大类应用推出的芯片的性能已经难以满足系统厂商的需求,同时对于系统厂商而言,如果在产品中只是使用通用芯片,则产品难以和其他使用相同芯片的公司差异化竞争。

芯片在系统中的性能可以拆解成两个要素,即芯片本身的性能以及芯片对于应用的适配度。在过去,由于摩尔定律发展很快,因此芯片本身性能前进很快,系统厂商难以设计出性能超过传统半导体公司通用芯片的芯片产品;而如今,随着摩尔定律发展减缓,芯片对于应用的适配度成为更主要的因素,系统厂商有机会能组织起一支团队并基于自己对于应用理解上的优势,设计出一款性能在自己的系统中超过通用芯片的芯片产品。

在这样时代范式发生变化的情况下,上一代通用芯片平台公司的业务模式必须作出相应改变,否则就难以跟上潮流。然而,不少芯片公司由于在通用平台芯片大行其道的时候过于成功,反而由于惯性太大难以在短时间内作出相应改变。以高通为例,在移动计算时代,高通靠着在移动通信标准领域的话语权,其通用芯片平台能取得非常大的成功;而随着进入人工智能和大数据时代,高通即不掌握人工智能技术标准制定的话语权,也没有系统厂商这样能精准把握终端用户需求的能力,因此如果还是想要走通用芯片平台的路子会导致在规划芯片时候战略过于保守,从而失去市场份额。

举例来说,在移动端,大家都知道手机SoC配上AI专用加速器模组已经成为大势所趋。事实上,手机SoC配上AI加速器正是由华为、苹果、三星等手机系统厂商根据自己对于用户需求的理解,在自研芯片上率先实现,从而引领了风潮。反观高通,由于对于移动端AI这件事一直犹豫不决,不敢确定手机搭载AI功能到底是伪需求还是真需求,因此一直不敢在SoC中加入真正的AI加速模组,而只是采取保守策略,拿原来的Hexagon DSP模组修修改改,这样就实际上在移动端AI的竞赛中落后了(AI加速器模组的设计牵涉到运算通路、内存访问和软件算法的协同优化,因此光基于DSP的修改往往是不够的)。

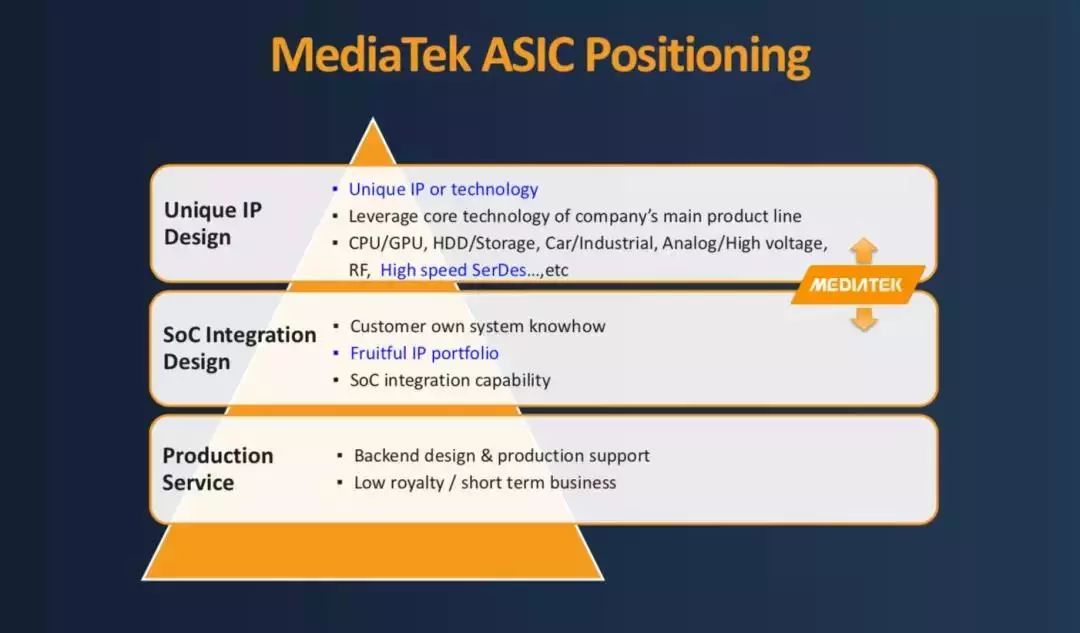

为了能搭上人工智能时代的班车,上一代通用芯片平台公司必须作出相应布局或改变。如果通用芯片公司对下一代技术布局够早,能占据下一代技术和生态的制高点,那么可以把生态作为竞争壁垒并继续推出通用平台芯片。Nvidia可以说是这样的一个典型例子,依靠在人工智能和CUDA生态上的早期布局,因此可以在人工智能时代继续靠通用GPU芯片把握大量的市场份额。我们看到高通进入小型服务器和边缘计算正是对于下一代技术进行布局的尝试。如果无法把握住下一代技术,那么传统通用芯片公司也可以帮助系统公司做芯片,将一部分业务转型为设计服务,例如联发科就是这样做的典型。当然,如果要转型做设计服务,那么就意味着放弃了高利润,如何完成平稳转型将是另一个挑战。

联发科于去年宣布将在设计服务业务上加大投入,可以看作是通用芯片厂商转型的例子。

结语

高通发布Cloud AI 100面对云端和边缘计算,可以看作是高通希望能搭上人工智能班车的一个尝试。在系统厂商纷纷自研芯片的今天,传统通用芯片厂商必须设法应对这样的挑战,其中一个办法就是布局下一代技术。高通希望通过布局下一代边缘计算计算,提前抓住技术制高点,从而能依靠生态上的优势来抓住市场而无须与自研芯片的客户直接竞争。