英伟达又放了一个大招:生成式AI上云

2023-06-21

11:08:33

来源: 杜芹

点击

随着AI技术的快速发展和广泛应用,越来越多的组织和企业开始将其AI工作负载迁移到云上,以便更好地利用云计算的弹性和可扩展性。ChatGPT这样的大模型应用爆火之后,生成式AI也开始往云上迁移。

生成式AI上云,提出了怎样的要求?

NVIDIA网络亚太区高级总监宋庆春表示,生成式AI是一个新的任务场景,需要非常大的AI集群,但上面运行的任务并不是传统的Micro Service这类的业务,而是几个有限的大型任务,然后通过云的方法给我们的用户提供服务。InfiniBand无疑是最好的选择,但确实有些用户比较有意愿用以太网去做生成式AI云。对此,NVIDIA于近日推出了全球首个专为生成式AI而构建的以太网网络平台和网络架构 —— Spectrum-X,便于客户在云环境中构建自己的生成式AI或者AI工作负载,提升网络性能。

如今,NVIDIA开创出了两个不同的基于AI的应用场景:

1)在大规模、大算力、高性能的场景下,NVIDIA创造了一个新的网络应用场景——面向AI工厂的应用场景,NVLink+InfiniBand网络的黄金组合被普遍用于这个场景。最近一些大语言模型的成功都是在采用这种高性能的NVLink+InfiniBand 无损网络架构,为大模型的训练提供了超大规模的、高性能的数据中心算力,支撑大语言模型对算力和性能的需求;

2)AI云的应用,首先如果只是普通的云计算需求,用传统以太网网络就行了。而面向多租户、工作负载多样性,需要融入人工智能和生成式AI的应用场景,现在就可以采用全新的Spectrum-X高性能网络平台,使客户在高性能的云环境中构建自己的生成式AI或者AI工作负载。

“网络已经成为生成式AI或AI工厂中的计算单元,就像InfiniBand 网络不仅仅负责通信,也是AI训练过程中计算单元的一部分。因此,我们不仅要考量CPU和GPU提供的计算能力,还需要将网络的计算能力纳入考虑范围。”宋庆春指出。

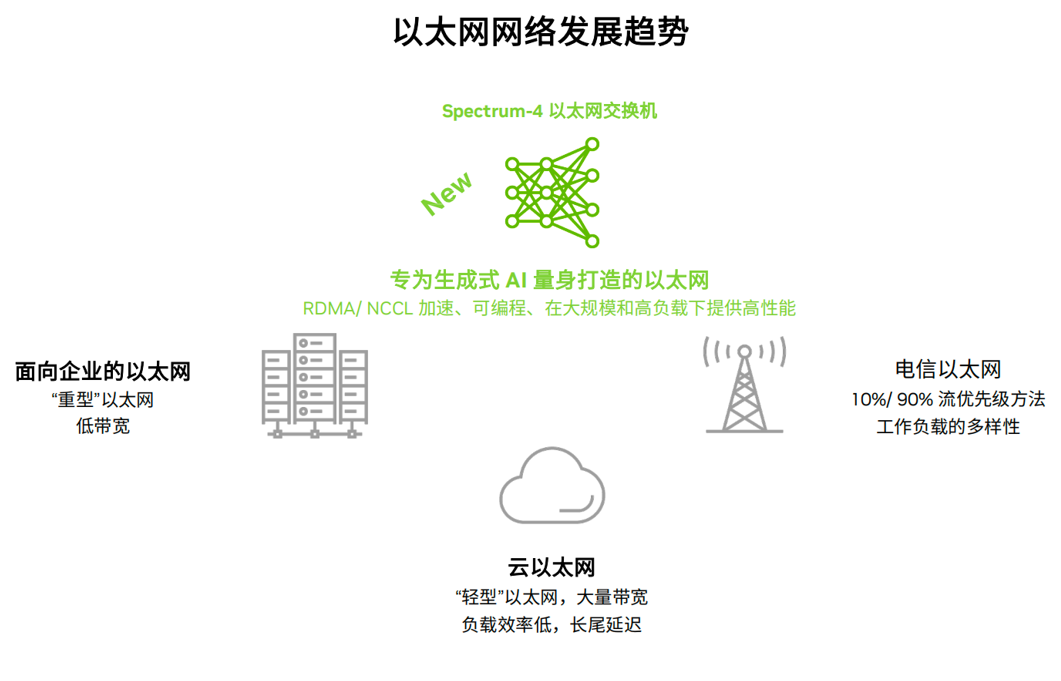

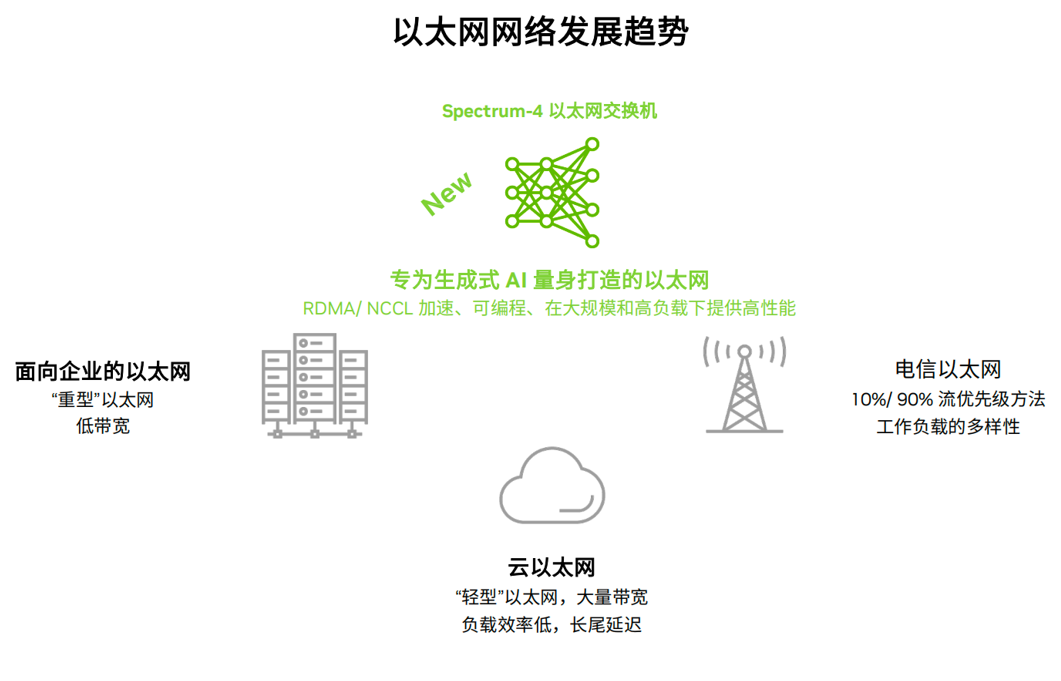

为什么NVIDIA要在云场景单独增加一个网络架构,支撑AI工作负载?据NVIDIA网络技术专家崔岩的介绍,传统以太网用于网络管理或用户接入网络,应用程序都是松耦合的。而AI工作负载对带宽、延迟和抖动敏感度更高。因此,不同的云场景需要不同的以太网络:面向企业应用的以太网需要支持很多复杂的网络功能,但是对网络带宽的需求不高,更多的是南北向的网络流量;云上的以太网,需要较高的带宽,但是不需要复杂的功能,上面运行的负载效率低,会有长尾延时和抖动的情况;还有专门用于电信行业的以太网,需要支持完全和数据中心不一样的功能;而面向生成式AI,前面的三种网络都不是最佳的选择,NVIDIA Spectrum-X创造了全新的网络功能和用途,可对生成式AI进行加速,在大规模和高负载下提供高性能。

传统以太网络更加适合南北向数据为主的流量和应用访问,人工智能需要成百上千个GPU来处理单一或者很少的几个AI工作负载和计算,更多的是东西向、分布式、紧耦合的应用,这就对数据传输有更高的要求。所以一定要构建一个无损的网络下的RoCE,可以在以太网架构下做到不丢包,支持以太网上的RDMA,满足高带宽和高利用率的要求。Spectrum-X这种新的网络架构主要是解决数据中心内部东西向流量的加速和性能需求。

Spectrum-X的四大主要特性实现大规模、可扩展

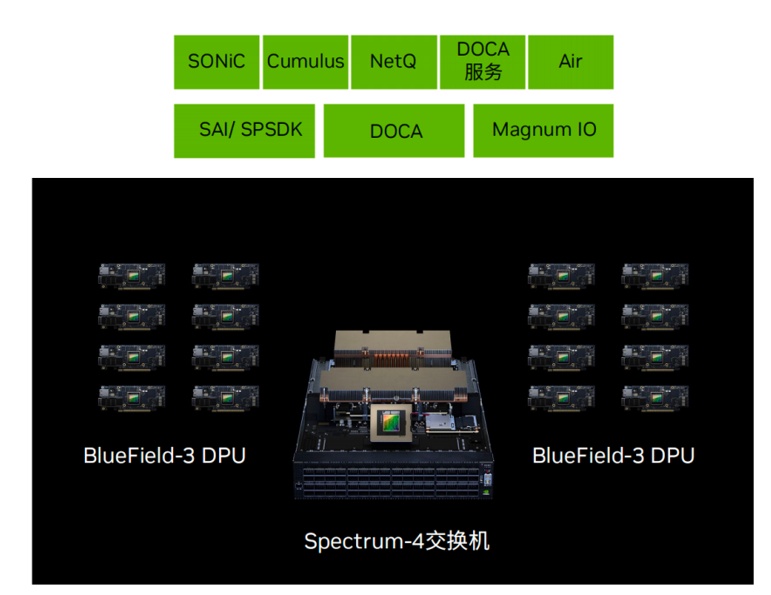

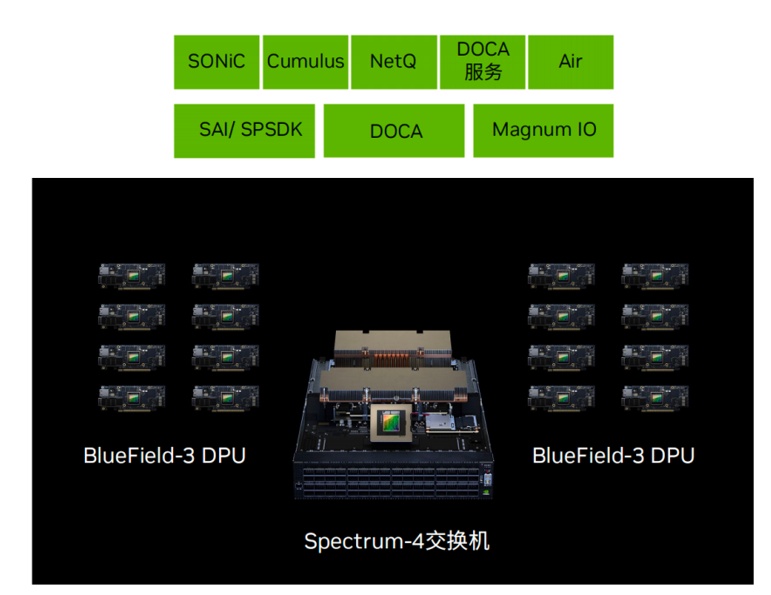

Spectrum-X网络平台集NVIDIA Spectrum-4、BlueField-3 DPU、LinkX线缆/模块和加速软件于一身。其中Spectrum-4系统具有1000 亿个晶体管,采用台积电的4N工艺,交换带宽容量为51.2Tb/s,采用了100G SerDes,支持64个800G端口或128个400G端口,配合BlueField-3 DPU实现端到端的优化。凭借无损网络、动态路由、流量控制、性能隔离这四大主要特性可以实现全新的AI云网络。

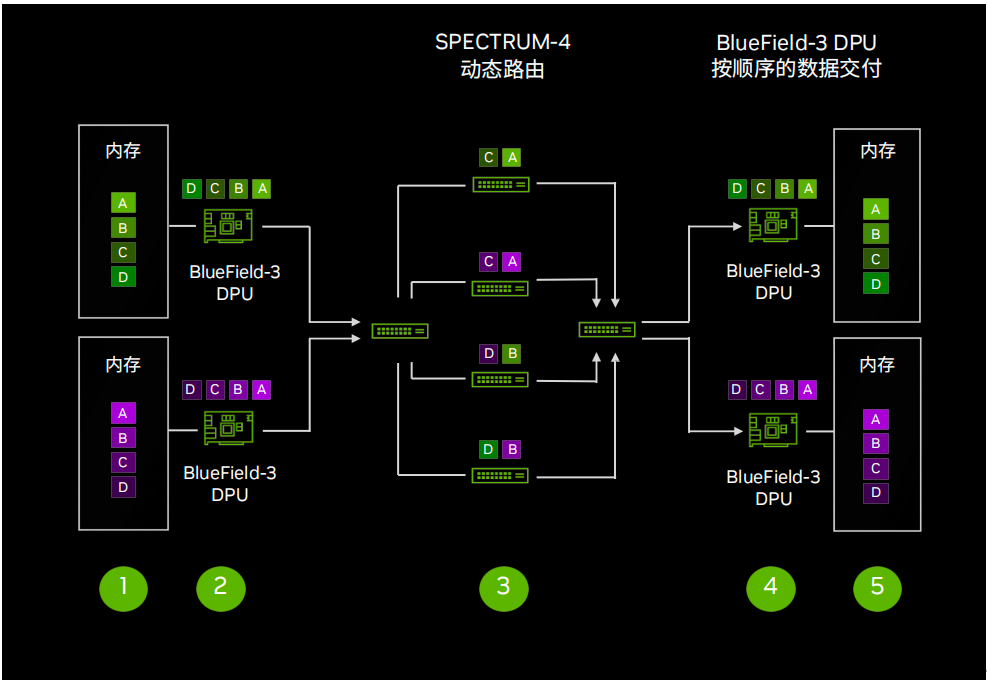

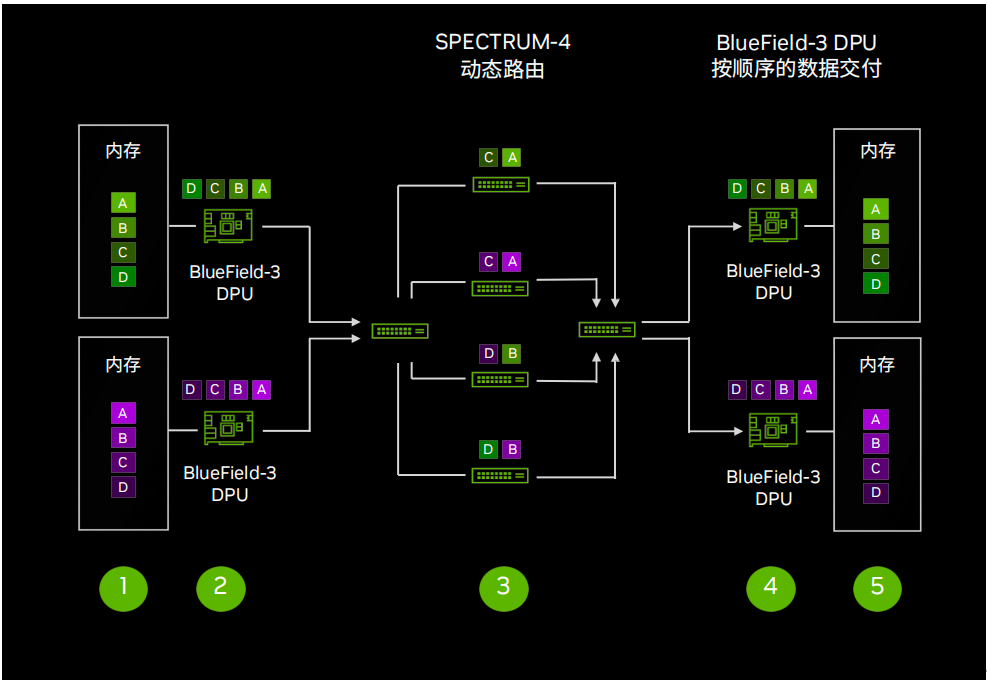

崔岩介绍到,Spectrum-X基于无损以太网实现动态路由,并重点对面向AI业务的集合通信库(NCCL)去做RoCE优化。具体原理是,在发送端通过BlueField-3 DPU将数据发送到交换网络,然后Spectrum-4 交换机将数据包分发到所有最佳的可用路线,在接收端BlueField-3 DPU进行数据乱序重组。相比传统以太网,其有效数据吞吐量提升了1.6倍,每条链路都可以得到充分利用。

无损网络对生成式AI是非常重要的技术。“对于大模型来言,往往需要投入数月或数周的时间来进行一次训练,如果出现问题,就需要重新调整或中断训练,这几乎是无法接受的成本。传统以太网的丢包重发机制在训练中是不可接受的,因为重发会导致训练速度变慢。”NVIDIA网络市场总监孟庆表示。

利用BlueField-3 DPU和Spectrum-4交换机实现动态路由的工作原理

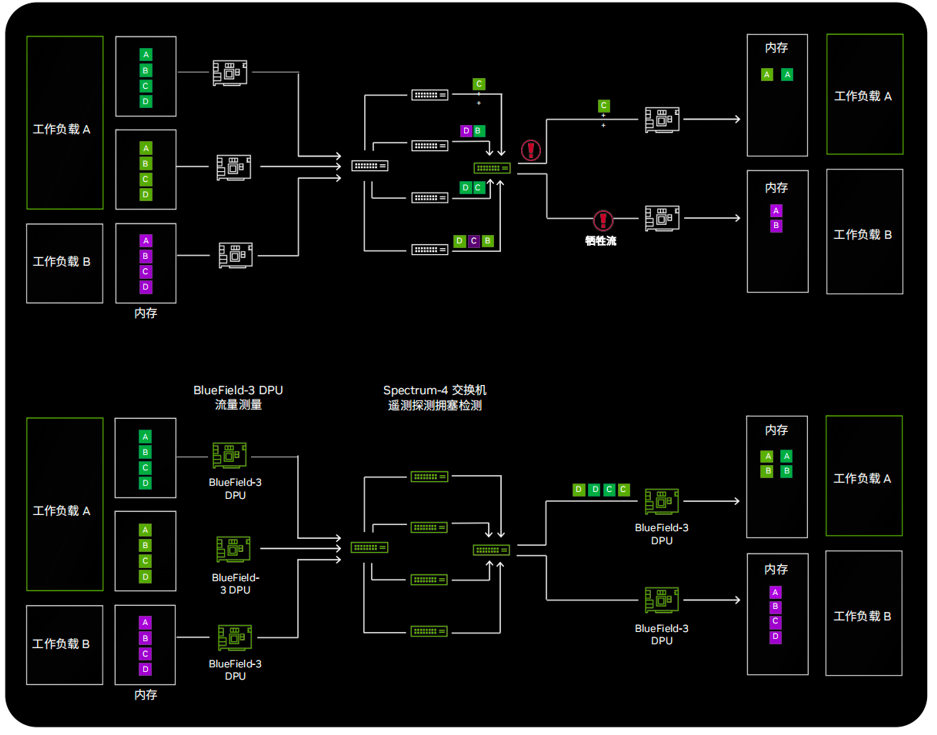

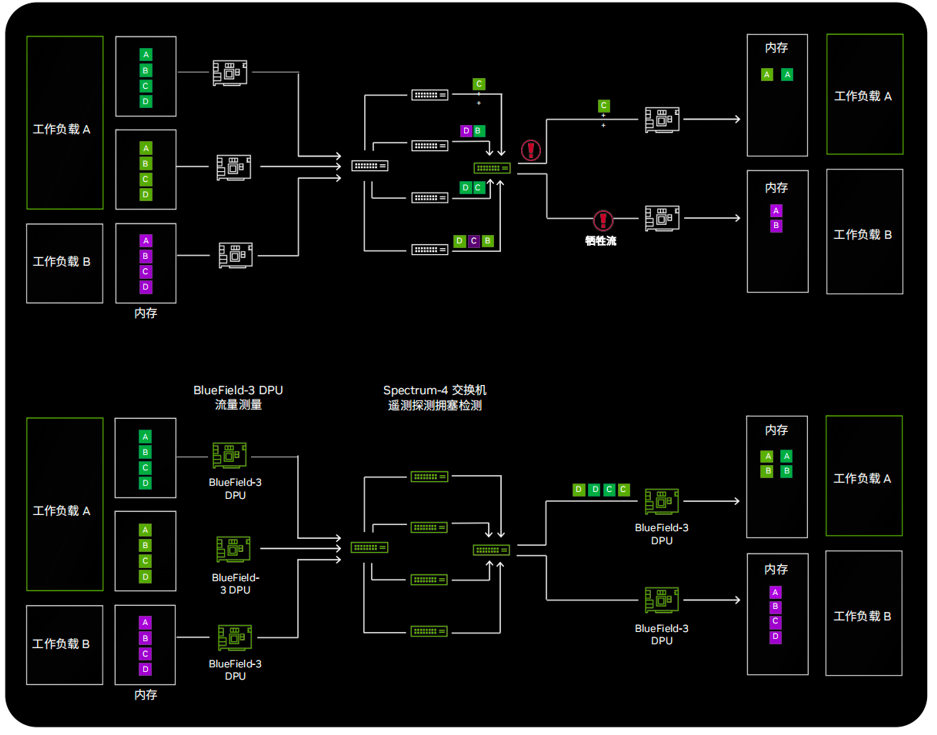

再一个是利用可编程拥塞控制机制实现性能隔离。在传统的以太网中,不同的工作负载会影响彼此的性能,Spectrum-X通过实时检测拥塞状况并通知给主机端的BlueField-3 DPU,利用BlueField-3 DPU进行可编程拥塞控制技术监控和控制数据流,最终实现不同工作负载之间的性能隔离,每个工作负载都能达到Bare Metal的性能。。

利用可编程拥塞控制机制实现性能隔离

在推动Spectrum-X时,NVIDIA身先士卒,基于最新开发的Spectrum-X平台,NVIDIA正在构建超大规模生成式AI云超级计算机,命名为Israel-1,NVIDIA将用来进行验证和优化Spectrum-X平台上的所有新技术,在解决问题的过程中不停地更新参考架构,并将所有经验分享给使用Spectrum-X的用户。NVIDIA投入了256台基于NVIDIA HGX平台的Dell服务器,共有2048 个 GPU,同时有2560个BlueField-3 DPU、80多台Spectrum-4以太网交换机,能提供8 EFlop/s(8000PFlop/s)的峰值AI训练性能。建成之后,这将是全球性能排名靠前的AI超级计算机之一。

网络成为重要的计算单元

计算机产业正在经历两个根本性转变:一是,CPU性能无法持续增长,每五年提升十倍的能力已经不再可能,且无法以相同的成本和电力消耗维持算力的增长。二是,在大规模模型的背景下,对数据中心规模和算力的需求不断创新,并推动了分布式计算的需求。当GPU数量扩展到成千上万时,性能不再仅依赖于单一GPU,也不再仅依赖于单一服务器,而是更加依赖于网络的性能。因此,网络已成为计算机产业中非常重要的一个计算单元。

为了实现加速计算,NVIDIA提出了一套全栈加速计算架构,从底层到最上层都对人工智能功率负载进行全新的设计。具体来看:在底层硬件方面,NVIDIA通过CPU、GPU和DPU提供了3U一体多样的硬件计算平台和网络通信平台;中间是系统软件、加速库和相应的平台;一个值得关注的点是,其从客户应用角度提供了更多的应用框架。

结语

“生成式AI一定是性能为王的市场,所以我们关注的就是性能。InfiniBand+NVLink无疑是性能最好的,然后是Spectrum-X,性能最低的就是传统的以太网。”宋庆春表示,“Spectrum-X让云客户获得不错的性能,又能够享受不错的便利性,避免了用传统的以太网导致这么大的AI基础设施投入却得不到相对比较好的性能的结果。”

Spectrum-X是NVIDIA创造的一个新的市场,这也是NVIDIA在大模型应用领域祭出的又一大招。它将大大节约生成式AI的训练成本,缩短训练时间,让大模型尽快面市。引用NVIDIA创始人兼首席执行官黄仁勋的话来说:买的越多,省的越多。

生成式AI上云,提出了怎样的要求?

NVIDIA网络亚太区高级总监宋庆春表示,生成式AI是一个新的任务场景,需要非常大的AI集群,但上面运行的任务并不是传统的Micro Service这类的业务,而是几个有限的大型任务,然后通过云的方法给我们的用户提供服务。InfiniBand无疑是最好的选择,但确实有些用户比较有意愿用以太网去做生成式AI云。对此,NVIDIA于近日推出了全球首个专为生成式AI而构建的以太网网络平台和网络架构 —— Spectrum-X,便于客户在云环境中构建自己的生成式AI或者AI工作负载,提升网络性能。

如今,NVIDIA开创出了两个不同的基于AI的应用场景:

1)在大规模、大算力、高性能的场景下,NVIDIA创造了一个新的网络应用场景——面向AI工厂的应用场景,NVLink+InfiniBand网络的黄金组合被普遍用于这个场景。最近一些大语言模型的成功都是在采用这种高性能的NVLink+InfiniBand 无损网络架构,为大模型的训练提供了超大规模的、高性能的数据中心算力,支撑大语言模型对算力和性能的需求;

2)AI云的应用,首先如果只是普通的云计算需求,用传统以太网网络就行了。而面向多租户、工作负载多样性,需要融入人工智能和生成式AI的应用场景,现在就可以采用全新的Spectrum-X高性能网络平台,使客户在高性能的云环境中构建自己的生成式AI或者AI工作负载。

“网络已经成为生成式AI或AI工厂中的计算单元,就像InfiniBand 网络不仅仅负责通信,也是AI训练过程中计算单元的一部分。因此,我们不仅要考量CPU和GPU提供的计算能力,还需要将网络的计算能力纳入考虑范围。”宋庆春指出。

为什么NVIDIA要在云场景单独增加一个网络架构,支撑AI工作负载?据NVIDIA网络技术专家崔岩的介绍,传统以太网用于网络管理或用户接入网络,应用程序都是松耦合的。而AI工作负载对带宽、延迟和抖动敏感度更高。因此,不同的云场景需要不同的以太网络:面向企业应用的以太网需要支持很多复杂的网络功能,但是对网络带宽的需求不高,更多的是南北向的网络流量;云上的以太网,需要较高的带宽,但是不需要复杂的功能,上面运行的负载效率低,会有长尾延时和抖动的情况;还有专门用于电信行业的以太网,需要支持完全和数据中心不一样的功能;而面向生成式AI,前面的三种网络都不是最佳的选择,NVIDIA Spectrum-X创造了全新的网络功能和用途,可对生成式AI进行加速,在大规模和高负载下提供高性能。

传统以太网络更加适合南北向数据为主的流量和应用访问,人工智能需要成百上千个GPU来处理单一或者很少的几个AI工作负载和计算,更多的是东西向、分布式、紧耦合的应用,这就对数据传输有更高的要求。所以一定要构建一个无损的网络下的RoCE,可以在以太网架构下做到不丢包,支持以太网上的RDMA,满足高带宽和高利用率的要求。Spectrum-X这种新的网络架构主要是解决数据中心内部东西向流量的加速和性能需求。

Spectrum-X的四大主要特性实现大规模、可扩展

Spectrum-X网络平台集NVIDIA Spectrum-4、BlueField-3 DPU、LinkX线缆/模块和加速软件于一身。其中Spectrum-4系统具有1000 亿个晶体管,采用台积电的4N工艺,交换带宽容量为51.2Tb/s,采用了100G SerDes,支持64个800G端口或128个400G端口,配合BlueField-3 DPU实现端到端的优化。凭借无损网络、动态路由、流量控制、性能隔离这四大主要特性可以实现全新的AI云网络。

崔岩介绍到,Spectrum-X基于无损以太网实现动态路由,并重点对面向AI业务的集合通信库(NCCL)去做RoCE优化。具体原理是,在发送端通过BlueField-3 DPU将数据发送到交换网络,然后Spectrum-4 交换机将数据包分发到所有最佳的可用路线,在接收端BlueField-3 DPU进行数据乱序重组。相比传统以太网,其有效数据吞吐量提升了1.6倍,每条链路都可以得到充分利用。

无损网络对生成式AI是非常重要的技术。“对于大模型来言,往往需要投入数月或数周的时间来进行一次训练,如果出现问题,就需要重新调整或中断训练,这几乎是无法接受的成本。传统以太网的丢包重发机制在训练中是不可接受的,因为重发会导致训练速度变慢。”NVIDIA网络市场总监孟庆表示。

利用BlueField-3 DPU和Spectrum-4交换机实现动态路由的工作原理

再一个是利用可编程拥塞控制机制实现性能隔离。在传统的以太网中,不同的工作负载会影响彼此的性能,Spectrum-X通过实时检测拥塞状况并通知给主机端的BlueField-3 DPU,利用BlueField-3 DPU进行可编程拥塞控制技术监控和控制数据流,最终实现不同工作负载之间的性能隔离,每个工作负载都能达到Bare Metal的性能。。

利用可编程拥塞控制机制实现性能隔离

在推动Spectrum-X时,NVIDIA身先士卒,基于最新开发的Spectrum-X平台,NVIDIA正在构建超大规模生成式AI云超级计算机,命名为Israel-1,NVIDIA将用来进行验证和优化Spectrum-X平台上的所有新技术,在解决问题的过程中不停地更新参考架构,并将所有经验分享给使用Spectrum-X的用户。NVIDIA投入了256台基于NVIDIA HGX平台的Dell服务器,共有2048 个 GPU,同时有2560个BlueField-3 DPU、80多台Spectrum-4以太网交换机,能提供8 EFlop/s(8000PFlop/s)的峰值AI训练性能。建成之后,这将是全球性能排名靠前的AI超级计算机之一。

网络成为重要的计算单元

计算机产业正在经历两个根本性转变:一是,CPU性能无法持续增长,每五年提升十倍的能力已经不再可能,且无法以相同的成本和电力消耗维持算力的增长。二是,在大规模模型的背景下,对数据中心规模和算力的需求不断创新,并推动了分布式计算的需求。当GPU数量扩展到成千上万时,性能不再仅依赖于单一GPU,也不再仅依赖于单一服务器,而是更加依赖于网络的性能。因此,网络已成为计算机产业中非常重要的一个计算单元。

为了实现加速计算,NVIDIA提出了一套全栈加速计算架构,从底层到最上层都对人工智能功率负载进行全新的设计。具体来看:在底层硬件方面,NVIDIA通过CPU、GPU和DPU提供了3U一体多样的硬件计算平台和网络通信平台;中间是系统软件、加速库和相应的平台;一个值得关注的点是,其从客户应用角度提供了更多的应用框架。

结语

“生成式AI一定是性能为王的市场,所以我们关注的就是性能。InfiniBand+NVLink无疑是性能最好的,然后是Spectrum-X,性能最低的就是传统的以太网。”宋庆春表示,“Spectrum-X让云客户获得不错的性能,又能够享受不错的便利性,避免了用传统的以太网导致这么大的AI基础设施投入却得不到相对比较好的性能的结果。”

Spectrum-X是NVIDIA创造的一个新的市场,这也是NVIDIA在大模型应用领域祭出的又一大招。它将大大节约生成式AI的训练成本,缩短训练时间,让大模型尽快面市。引用NVIDIA创始人兼首席执行官黄仁勋的话来说:买的越多,省的越多。

责任编辑:sophie

-

- 半导体行业观察

-

- 摩尔芯闻