现在人们普遍认为,以摩尔定律的预期速率进行器件缩放,以及相应地,完全通过改进通用CPU来实现功率/性能缩放的时代将结束。摩尔定律的终结将增加对特定领域加速器(DSA)的需求和使用,以满足云基础设施、网络基础设施和物联网/无线边缘等应用对芯片功率和性能要求。作为一个重要的数据点,近年来的HotChips会议展示了许多面向基础设施应用的领域特定SoC,包括几个神经网络加速器、云处理、安全处理和交换结构。

异构集成-Chiplet

DSA通常是作为单片IC开发和实现的。在单片ASIC(专用集成电路)中,加速器中的所有元件都是在一个硅片上用一种工艺设计和制造的。随着工艺几何图形的缩小,开发ASIC的成本变得高得令人望而却步,例如,在7nm工艺节点上的成本超过2.5亿美元[14]。在如今的发展过程中,只有非常大的市场容量才能证明定制ASIC的发展是合理的。

与一般用途的CPU相比,DSA通常服务于更小的市场。ASIC设计师试图通过整合大量第三方知识产权(IP)核来降低设计成本。第二种控制成本的方法是选择一个更经济的工艺节点,比如16nm,而不是7nm甚至22nm。在太老的节点上,如果要实现应用所需的全部功能,可能会使硅片的面积太大而无法经济地制造。

异构集成系统提供了一种新的设计方案。在这些系统中,产品中的不同组件在独立的裸片上设计和实现,称为chiplet。不同的裸片可以使用不同的工艺节点制造,甚至可以由不同的供应商提供。第三方chiplet可以减少设计时间和成本。但这种方法的可行性常常受到片间互连的性能和可用性的限制。直到最近,片间互连的功耗和性能比片内互连要糟糕3-4个数量级。这需要强制进行高带宽访问的资源,比如外部内存接口和主机接口不能移出芯片。已经开发出了几种新技术从简单到高度并行的高速串行接口,来改进片间连接的电源效率。新的封装技术已被开发,来支持这些不同接口的多芯片封装。

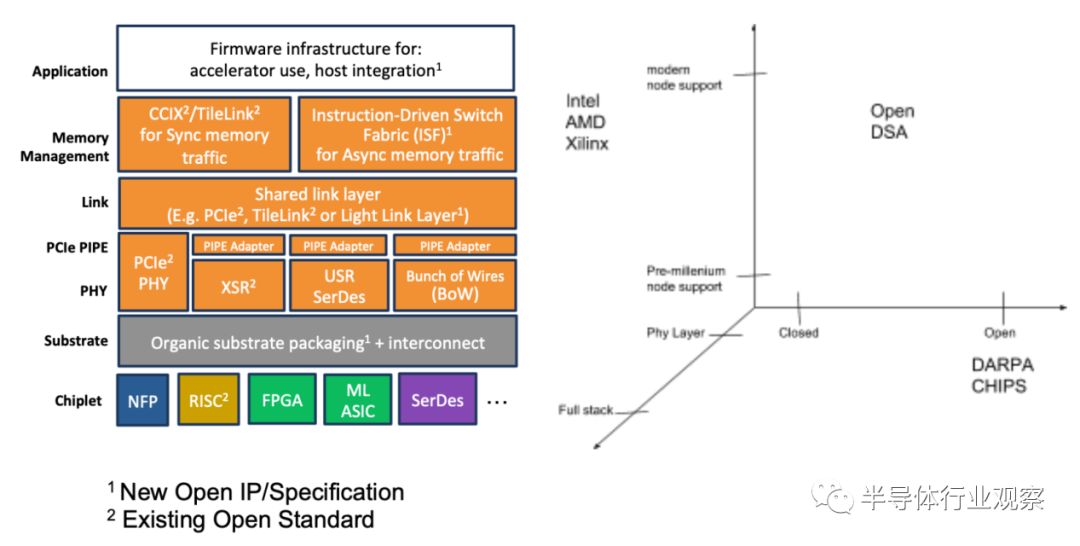

chiplet技术的发展引起了大型商业公司和政府研究机构的关注。Intel、AMD、Intel和Xilinx在多chiplet系统上处理完整的堆栈连接、逻辑数据传输和应用程序执行。他们的工作主要使用专有协议,并且是封闭系统,整个异构系统由单个供应商控制。而云计算和网络运营商的能力、性能和成本要求将根据加速器在网络中的部署位置而有所不同。运营商也更愿意通过跨多个供应商组合一流的解决方案来组装定制化的加速器。

目前的标准化工作在很大程度上局限于片间通信的PHY(物理层)协议。最著名的标准是基于开放式高带宽存储器(HBM)接口的高性能3D堆叠存储器。美国国防部高级研究计划局(DARPA)的计划[18]专注于创建和标准化chiplet之间的开放连接协议。一个限制是,该计划侧重于支持对国防工业重要但可能与商业发展无关的工艺节点。这将协议限制在与接口的模拟性能有一定限制的工艺上。

DSA的另外两个属性必须在多chiplet架构中解决。首先是内存管理。DSA通常连接到主处理器,完整的应用程序流是DSA本身和主处理器上的数据处理过程的有机结合。操作协同是通过协调主处理器和DSA之间的内存状态来实现的。一般是通过内存一致性协议或由程序员管理的主处理器和DSA之间的数据传输来实现的。另一种方式是通过主机上的操作系统控制和管理加速器。

在本文,我们呼吁开发开放体系结构的标准,并开发可以作为开放体系结构模板和初始平台的原型产品。

我们(开放领域特定架构(ODSA)工作组)提出了一种低成本、高性能的开放加速器架构,以解决开发DSA的全部需求,包括以下组件:

我们还建议使用以下组件提供平台原型:

图1将ODSA工作组与工业界和政府最近的努力成果chiplet进行了对比。具体来说,相对于DARPA计划,ODSA侧重于关注技术栈之上的内存管理协议。相对于来自大公司的产品,ODSA提倡一种开放的体系结构,使得来自多个供应商的产品可以互操作。综合起来,这些特性将降低在广泛应用中开发和部署高能效、高性能加速器所需的成本和时间。

开放式体系结构将使供应商能够开发同类最佳的DSA:

-

开发人员在开发产品时,可以将异构的同类最佳组件结合起来。合并来自多个供应商的裸片。此外,对于性能较低的零件,开发人员甚至可以重复使用当前以封装IC形式出售的裸片。

-

该架构将通过在廉价的基底上采用多芯片互连的多种低功耗方法,以低单位成本提供高性能、多兆比特互连。

-

该架构将通过支持大量的硬件和软件重用来降低开发成本。

传统意义上讲,加速器被实现为单片的ASIC,其中会包括一个裸片上的所有功能,这些功能通常与系统中的其他芯片连接,具有中、远程SerDes接口。这允许在子块之间的通信在功耗和占用硅片面积上达到最优。

ASIC实现趋势

传统意义上,IC设计者在开发下一代芯片时有两种选择。开发新芯片的主要方法是在下一个可用的工艺节点中利用增加的带宽、增加的处理能力(频率、处理核心)和其他特性更新。第二种方法是在同一个工艺节点中开发其他新特征,以减少新工艺和新工具的投资。

在摩尔定律的帮助下,设计者通常可以在下一个工艺节点将系统中的两个独立的ASIC组合成一个单片设计,从而提高频率。当多个部件组合成一个单一的器件导致接口电源被移除时,这是移动到较小工艺的的动态功耗改进之外的额外好处。不幸的是,随着先进技术向越来越精细的功能转移,以实现面积和功率的扩展,实现这些器件的成本急剧上升。图2显示了随着设计迁移到高级工艺节点,开发成本的快速增长。对于许多市场和应用空间有限的加速器器件来说,这种额外的成本是不可接受的。

为了摊薄开发成本,ASIC的设计比实际需要的更大,因为它们需要被设计为满足各种应用所需功能的超集。不幸的是,功能的超集降低了工艺进步带来的好处,导致更复杂的芯片规格从而需要更多的精力来设计,布局,尤其是要开发出与更新的较小的工艺相匹配或超过增加的掩模和工艺成本的软件。即使这些芯片变得越来越复杂以降低投资成本,但由于更复杂的光刻和工艺(双,三次图案转移,EUV等),每个晶体管的成本下降也在放缓甚至停滞。

有了这些趋势,一个明显的选择似乎是在旧的工艺节点上构造非常大的单裸片。更新同一进程节点中的器件也会带来挑战。通常,上一节中所示的较小裸片的工艺几何结构和良率效益使其无法或不可能将两种不同的设计组合成一个芯片,并满足成本或分划线限制。虽然消除接口可以真正提高接口功率,但设备的总体成本增加使这一好处难以实现。

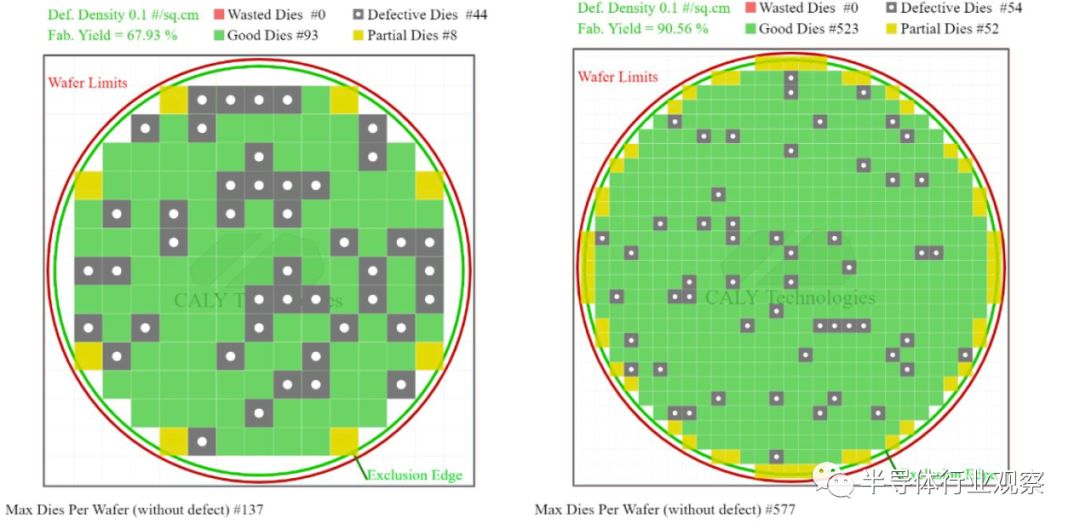

此外,大型裸片的缺陷、光刻工具中使用的分划板的局限性以及与层压板连接的可靠大型裸片的局限性也会影响成本。图3比较了两个裸片,一个10x10,另一个是20x20。只要使用非常好的d0(0.1),每300毫米晶圆的中,四个10x10裸片良率会比20x20裸片多29%。

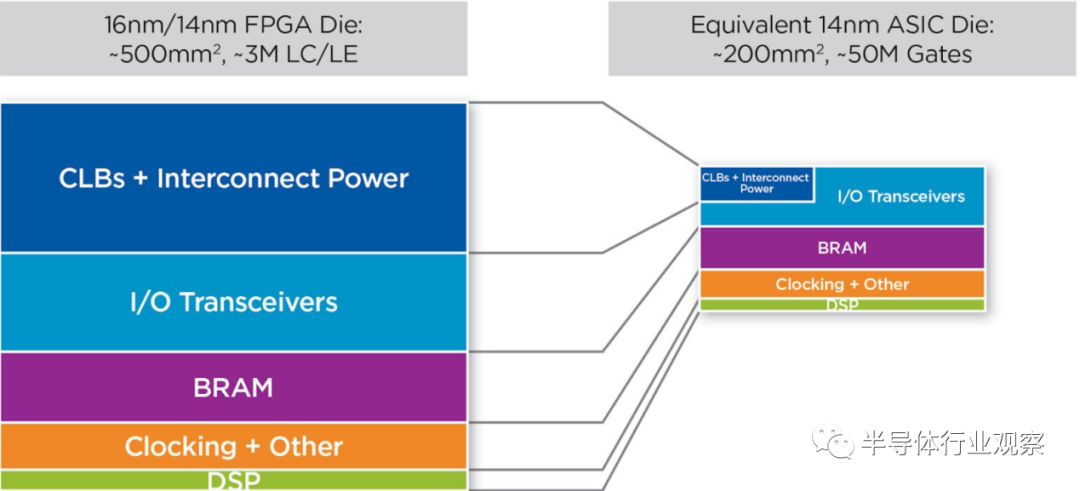

基于FPGA的设计是加速器的另一个实现方案,且开发成本非常低。许多加速器开发人员的应用程序服务于一个有限的市场,即使他们能够使用处理器和FPGA实现所需功能并具备显著成本和功率优势,他们也无法证明这笔费用的合理性。图4显示了使用相同工艺节点的ASIC实现相对于FPGA在面积和功耗方面有显著优势。

图4:ASIC与FPGA中相同内容的比较显示了显著的优势

Chiplet概述

在本文讨论的开放式体系结构中,我们探索了第三种途径,使用低功耗接口(如USR、束线(BoW)或新兴的112G SiP标准)实现多组件裸片的异构集成。通过在不同接口上分层公共协议,可以利用一种基于“构建块”的通用方法,通过简单地改变多芯片模块(MCM)的物料清单(BoM),在基板上创建新的系统。

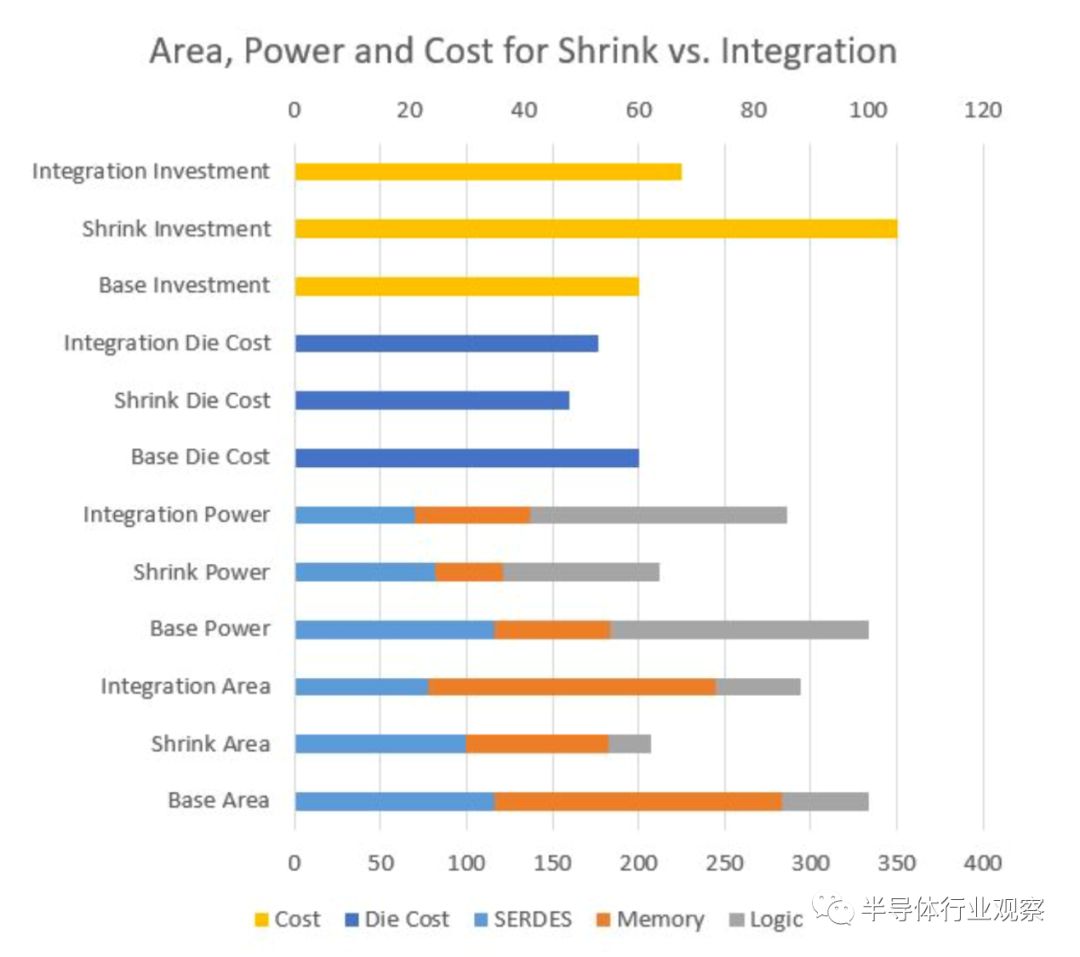

一些组件块(例如长距离SerDes块或电-光接口)可以在需要的地方迁移更高级的工艺节点,但是其他组件块可能保留在具有成本效益的节点中,以减少总体投资。如下图5所示,虽然没有达到技术缩减的相同面积和功率优势,但第三条路径通过显著减少接口面积和功耗,在更具成本效益的节点中比单片集成提供了相当大的面积和功率节省。虽然多芯片系统通常比单个芯片的成本更高,但这些面积和功耗节省可以在一定程度上抵消增量投资。

在这个图表中,基本投资被显示为原始设计的参考点,原始设计需要通过组合组件和通过集成或将更大的设计推送到新技术中来添加新功能来进行更新。集成到单个基板上可提供工艺缩减的带来的许多好处,而投资成本却大大降低。

基板上的集成系统还大大节省了电路板空间和走线延迟,节省了大量系统成本,通常可以抵消设计和集成MCM所增加的成本。

互连和外部接口

开发物理分解(异构)MCM解决方案的主要挑战之一是在裸片之间移动数据,同时保持具有竞争力的成本和可制造性。虽然高密度、低成本的封装解决方案方面在继续取得巨大进展,但在选择与当今可用于大批量制造的封装解决方案兼容的互连技术方面仍然具有显著优势。此外,使用经过验证的封装解决方案可以提高与外部互连(如PCI Express和以太网接口)的兼容性,这些接口可能是这些SiP解决方案所需要的。

多年来,人们一直在寻找一种“真正的互连”,以便在单个MCM中实现从裸片到裸片的通信。

挑战在于希望优化六个往往相互竞争但相互关联的因素:

理想的解决方案是一种可无限扩展(在细粒度分辨率下)、低功耗、高效率、对编程模型完全透明、可构建在低成本硅和封装技术中的互连技术。

一般来说,有三类技术服务于这个空间:

我们简要回顾了每一种die-to-die的通信技术。

传统的中长距离(MR和LR)SerDes(如PCI-Express、以太网等)作为die-to-die互连解决方案具有一些关键优势。这些SerDes接口倾向于以合理的速度/功率优化点在硅工艺节点的广泛选择中可用。为了支持传统的操作模式,大多数标准都在设计上包含了带宽扩展的概念。由于这些接口被广泛使用,因此集成到裸片和系统编程模型中往往是非常耐用和易于理解的。集成和使用这些接口所需的封装技术是广泛可用和廉价的。

然而,它们也存在一些明显的缺陷。由于这些实现往往是一般化的,并且集中于物理上大型系统(例如服务器或企业路由器)中的通信,因此与专用的die-to-die解决方案相比,它们的能量效率偏低且占用的硅片面积过大。模型虽然很好理解,但它的目的是在物理上和逻辑上不同的设备之间进行通信,因此往往包含固定的流控制和大量的系统开销,这些开销会增加延迟和复杂性,这在SiP这种理想通信场景中没有太大必要。

XSR/SiP是一种相对较新的SerDes接口,它以50Gb/s的速度node1开始引入,并且以100Gb/s的速度寻找未来的解决方案时在业界受到了更多的关注。XSR/SiP SerDes代表了一个高度优化的、通常非常高速的串行接口,它是专门为die-to-die通信而构建的。基于传统的SerDes体系结构(集成了时钟数据恢复电路),但是具有严格限制的插入损耗预算,这些XSR/SiP链路具有较高的能效和较小的硅片面积,允许在SiP内实现极高带宽的链接。这些往往被视为简单的“比特管”系统可以抽象为非常灵活的编程模型,但由于需要将前向纠错(FEC)应用于以优化功耗和面积后的100Gb/s速度的接口,因此可以引入显著的延迟。

与其他解决方案一样,基于XSR/SiP SerDes的互连也存在一些负面影响。为了在非常高的速度下支持良好的信号完整性,需要更高性能(因此更昂贵)的封装基板材料来支持大规模集成。裸片之间的总接口带宽可以非常有效地扩展,但在50或100Gb/s运行所需的电路开销要求最小接口带宽和增加带宽的单位为几百Gb/s,以实现功率和面积效率目标。最后,先进的硅工艺节点通常需要支持这些SerDE的设计,限制了系统设计者用正确的工艺实现。

USR-Femto-SerDes进一步针对特定的die-to-die通信进行了优化,采用了增强的信令方案(时钟转发、高级编码、多比特/多线传输等),以提供极为节能的解决方案。通过使用现有的封装技术,这些接口支持每条线的高数据速率,可以提供带宽和成本的良好平衡。虽然还不能达到100Gb/s XSR/SiP解决方案所能达到的绝对接口带宽,但USR设计可以提供相当高的功率效率。与XSR/SIP SerDes一样,系统集成模型可以是灵活且非常轻量级的,但是FEC可能需要以更高的数据速率应用以支持可接受的数据传输完整性。此外,USR串行接口通常是自定义的“强化”宏,通常涉及专有编码方案,这意味着可能需要对特定的过程技术进行自定义设计才能实现它们。与传统技术的互操作性和兼容性也可能带来挑战。

实现die-to-die接口的最简单解决方案是一个较大位宽由时钟驱动的并行总线,类似于用于DDR的内存接口。从系统和软件的角度来看,这些设计灵活、可扩展、易于实现和使用,几乎可以在任何硅工艺中实现,在支持低电压的更高级节点上实现极低的功耗。总的来说,BoW解决方案将代表最低功率、最密集的解决方案,但有一个显著的缺点:一旦接口超过一定的带宽,封装成本将显著增加。由于目前的有机封装衬底技术的限制,一旦裸片之间的带宽超过每毫米约400Gb/s,就需要转向基于硅的互连介质或高密度有机溶液。

高带宽存储器(HBM)一直是驱动行业多芯片集成的主要参与者,它使用硅插接器上相对低速的并行接口,采用非常宽的接口和良好的布线间距。AIB是DARPA芯片项目与行业合作伙伴共同开发的一种接口,在数据速率和硅桥或插入技术上的精细间距布线使用方面与HBM大体相当。这两种技术都实现了相对较高的带宽密度,但也需要相对复杂的硅基互连技术。

上面讨论的每个解决方案都倾向于优化这些因素中的一部分或大部分,但在许多情况下,最佳解决方案高度依赖于应用。并行接口如BoW、AIB、HBM提供低功耗、低延迟和高带宽,但代价是需要在裸片之间连接许多线路。只有使用昂贵的插接器或桥接技术才能满足布线要求。相对于并行接口,SerDes提供了类似的带宽,但是会增加一些额外的能力和事务延迟。SerDes已被用于在各种标准中,用有限数量的物理线提供高带宽的off-die通信。然而,大多数SerDes,如那些用于以太网通信或PCI Express虽然面积有效,但能耗太大。USR SerDes提供off-die通信,其优点更接近于片上互连。然而,由于串行化开销,基于SerDes的通信通常会比片上网络带来更大的延迟。

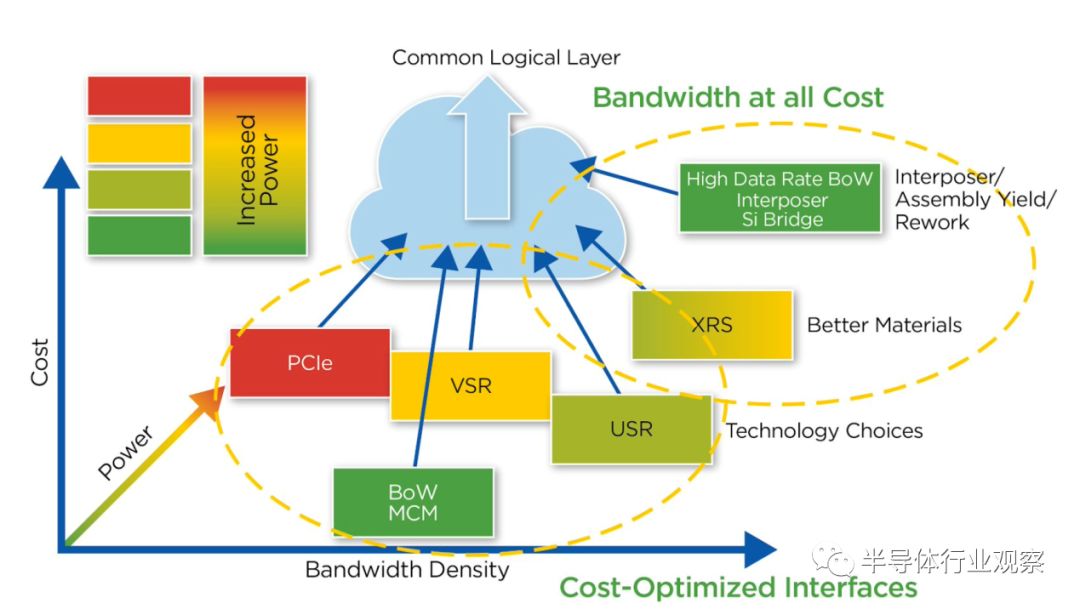

系统设计人员在选择 die-to-die的互连之前,应考虑其应用的所有相关要求。图6中的图表总结了每个接口在各种相关参数上的相对优势和劣势,例如优点图——硅和层压基板上的带宽密度与功率和带宽密度的比值。

本文讨论的ODSA通过使用一个通用的数据传输事务协议来抽象PHY协议。ODSA事务层允许系统设计者为其功能选择最佳接口,而无需指定特定的解决方案。如图7所示,多芯片系统基于预算限制、可用性、带宽和功率需求而利用多种接口技术。

基底与封装

在产品和市场需求的驱动下,实现了更高密度的集成,封装技术在过去几年经历了革命性的转变。对封装的要求已经从单纯地实现与外部世界的电气和机械连接,发展到现在支持多芯片封装中不同芯片之间的多种接口技术。

将多个芯片和/或封装集成到一个MCM中导致了更大的封装尺寸,这导致了更小的信号线和空间。如果不考虑相应的封装技术,就无法确定用于特定用途的最佳chip-to-chip接口。芯片之间的接口指导和影响封装技术的选择,特别是需要集成多个芯片的基板。封装正成为实现多芯片集成的关键领域之一。三个相关问题促使我们选择适合多芯片设计的封装技术:

-

chip-to-chip接口

-

成本限制和性能要求

-

多chiplet 封装的总尺寸

例如,在片间互连中的高线密度可能要求使用支持高线密度的基板或桥接技术。高带宽存储器(HBM)的启用可能是这一趋势的最好证明——因为HBM只能与ASIC集成在同一个封装中,而且此时只能在2.5D的硅中间层配置中集成。HBM芯片的外部互连是DRAM式的,需要大量的I/O。因此,它的封装使用了间距为55um、直径为25um的微凸块(u-bump)。在HBM2中,u型凸起的总数为4,942个。由于ASIC芯片在与HBM芯片通信时必须使用相同数量的I/O,所以ASIC芯片必须使用u-bump,并且u-bump的间距和直径也要类似。由于今天在有机基质中C4和Cu柱的最小允许凸起间距分别为130um和90um,硅中间层成为唯一可行的解决方案。

虽然硅基封装技术已经发展为批量制造解决方案,但成本和复杂性可能会阻止它们成为大多数低端应用的正确解决方案。标准的FC-BGA封装是一种较低成本的选择,支持多种互连技术(SerDes和BoW),但无法实现与硅基解决方案相同的带宽。

这种差异是显著的,因为硅中间层带来高成本,高制造复杂性和产量损失。设计和制作2.5D硅中介层封装的NRE成本很容易达到100万美元甚至更高,每个芯片的生产组装成本接近100美元。相比之下,设计和制造MCM组件的NRE成本仅为100万美元的一小部分,每个芯片的生产组装成本也远低于100美元。从经济上讲,摆脱硅中间层并回到传统的MCM封装具有很大的好处。

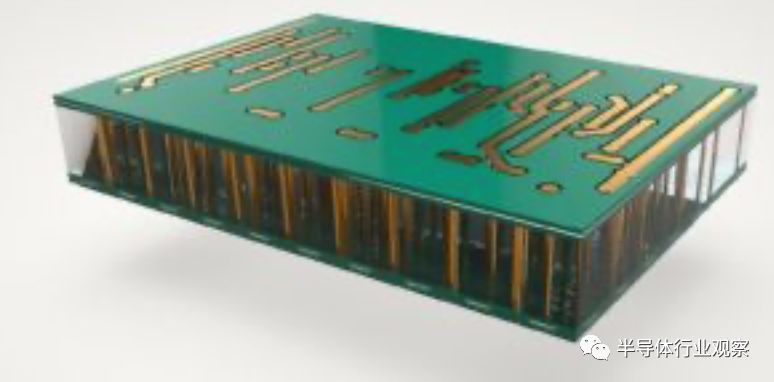

使用有机基板就像使用传统PCB一样。PCB和有机基板都是通过使用传统的蚀刻工艺制造的,而传统的蚀刻工艺不依赖于半导体制造设备的使用,而硅中介层为了实现精细间距而需要使用半导体制造设备。

封装尺寸是第二个需要考虑的问题,它主要由组件的总裸片尺寸决定。在翘曲和热膨胀问题达到极限之前,球栅阵列(BGA)封装可以可靠地达到75mm x 75mm的尺寸。BGA封装可以焊接或安装在插座上。栅格阵列(LGA)插座,可达到110mm x 110mm的大小。LGA插槽包括一个微小的叶弹簧,允许发生一些翘曲和膨胀。TE Connectivity拥有一个名为XLA sockets的LGA产品线,该产品线不仅提供了这种能力,还保证了良好的SerDes信号完整性,可以轻松地处理56G SerDes和112G SerDes。110mm x 110mm是一块大吐司的尺寸,可以容纳很多功能。

传统上,标准硅中介层仅限于光罩尺寸。对于大多数使用的硅制造设备,该掩模版极限在32mm x 26mm的范围内。更高级的解决方案包括缝合多个光罩场以形成更大的硅中间层,或者仅在需要它们的区域使用较小的硅中介层(“硅桥”)。

并行接口,如AIB或HBM,或提出的更通用的BoW接口方法,大大增加了可使用的封装技术的需求。BoW通常比串行解决方案具有更慢的信号速度,但芯片之间的互连明显更多。

根据芯片之间需要支持的带宽大小,可以选择不同的封装技术:

-

对于芯片之间的低到中带宽要求,可以使用相同的FC-BGA基板技术,但需要增加的是较小的线缆,而SerDes信号使用的是较大的线缆(20um线/空间)。

-

对于高带宽应用,信号线的数量需要最大化,因此线路和空间需要进一步大幅缩小。可以打印的最小几何图形总是在硅上,因此2.5D(或其他基于硅的技术,如EMIB)可以提供非常高的带宽密度。在实现显著的好处的同时,使用硅作为封装互连媒体也会导致复杂和昂贵的封装解决方案。

-

目前正在开发的一些新技术针对的是“中间空间”——这种解决方案成本更低,但仍然能够实现非常高的互连密度。这些解决方案包括在常规层(“2.1D”)的基础上加工额外的细间距层的有机层合板,以及一些新的晶圆级扇出技术,旨在实现HBM要求的类似布线密度。

USR SerDes互连技术的发展大大减少了半导体芯片之间通信所需的I/O总数。它允许有机基质提供裸片之间的互连,使成熟的MCM技术再次为我们服务。

传统的SerDes,以及不断发展的XSR和USR Fempto SerDes都有一个共同的优势,即信号线数量更少(运行速度更快)。这使得一个相当标准的封装解决方案成为可能,例如FC-BGA。

支持MCM集成的FC-BGA封装技术的主要新元素现在允许:

•

对于32/28nm节点,有一种比较保守的看法是封装大于~55mm会导致卡片装配出现问题。这一观点在过去几年里有了显著的发展,70mm的封装已经投入生产,80-100mm的封装已经在许多公司的路线图中。

•

需要在封装基板中使用低损耗的电介质,以便在将插入损耗保持在可接受水平的同时延长跟踪长度。

高速信号,如来自USR或LR SerDes的信号,可以通过硅中间层穿隧。典型的技术是利用几个相邻的裸片微凸块形成输出,以保持阻抗,从而保持SerDes的传统裸片凸点的信号完整性。还有更多的微凸点,还有更多的微凸点形成一个更紧密的接地凸点桶。。

然而,由于使用SerDes减少了对线数的要求,因此可以使用更便宜的玻璃甚至有机基板来构建大型多芯片封装。使用这些基板降低了总的封装开发成本。

在大多数加速应用程序中,在一个多chiplet产品中,在多个chiplet上数据路径可能同时运行执行。多个chiplet通过数据传输协议共享数据。相干协议使用硬件支持为软件开发人员在主机和DSA上提供一致的内存状态。提供这种一致性的成本与需要实现这种一致性的物理区域成比例。在非常大的范围内,实现一致性的延迟成本可能非常大,程序员对这种延迟的直接控制非常有限。有几种用于加速器状态一致性的开放协议,包括CCIX、TileLink和OpenCAPI。

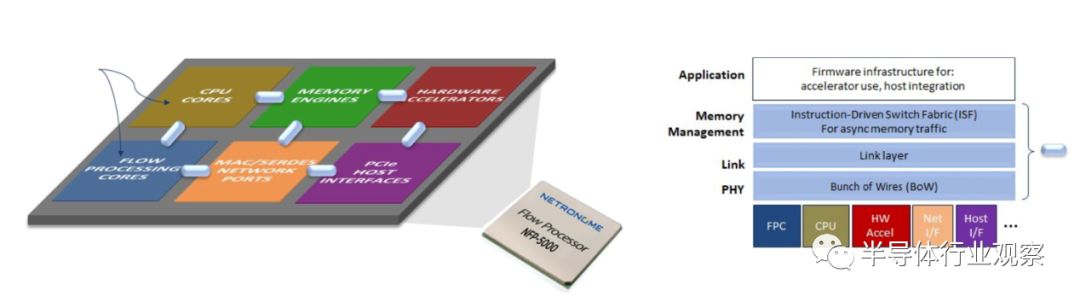

非相干数据结构是相干协议的替代方案。在具有非相干结构的系统中,开发人员显式地控制数据传输。TensorFlow是使用非相干数据传输的加速器的一个例子。为chiplet开发非相干数据结构有两种选择。一种选择是扩展片内结构以进行片外传输。大多数片上结构使用同步全局总线。这些总线不容易扩展到芯片外。第二种选择是使用片对片的非相干数据传输协议进行片对片的数据传输。PCI Express是最常见的片间非相干数据传输协议。但是,在封装中使用它的开销可能很大。Netronome开发了一种用于非相干数据传输的轻型可伸缩结构

技术实施证明要点

本节回顾了原型中使用的先进技术的证明点。具体来说,我们讨论了USR SerDes、基底和非相干数据传输协议的实现。

下文将讨论ODSA的原型实现。

在过去的几年中,出现了一种使用硅中介层或硅衬底的重要替代方案。这种选择是低成本基底和高能效USR SerDes的组合。这些USR SerDes的出现,特别是Kandou使用CNRZ-5调制技术的Glasswing SerDes的出现,使得可以在大型MCM上构建复杂的系统。CNRZ-5调制技术提供了NRZ形的接收眼,因此即使在高速率下也可以使用最小的均衡,从而降低了功率。

(1)在有机基质上的调制-CNRZ-5 vs PAM-4 vs NRZ

选择在有机封装上运行的SerDes上使用的调制技术非常重要。三个相关的选择是CNRZ-5,PAM-4和NRZ。在基底上使用PAM-4调制技术是一个糟糕的选择,因为它具有糟糕的本机错误性能,必须通过显著的、有时是高延迟的前向错误控制(FEC)块和/或大型大功率均衡器来保护。这种糟糕的本机性能的原因是PAM-4在同一链接上的“眼图”有大眼睛和小眼睛的组合,这是PAM-4的三个堆叠的眼睛的结果。来自大眼睛的能量反射到任何缺陷和接收器上。这种反射的能量会使小眼睛闭上。反射是USR/XSR链路的主要缺陷。非反射符号间干扰(ISI)也存在类似的影响。

PAM-4被下一代的XSR-SerDes所使用,这些SerDes正被开发用于光学模块应用。在这种应用中,一个大的系统FEC是用来保护光链路的,所以它是免费提供给直接将数据传送到光学链路上的电子链路的。在几乎所有其他应用程序中,重要的FEC块都需要与链接一起使用。这意味着他们通常需要增强均衡和FEC。OIF CEI-56G-XSR-PAM4互操作性协议的误码率是1E-9。

NRZ USR Phys功能强大,通常可以在没有FEC的情况下使用。在相同的波特率下,NRZ PHY的pin效率低于CNRZ-5 PHY。由于可用的裸片球数量有限,因此pin效率在USR应用中至关重要。降低的pin效率直接降低了使用NRZ的裸片的边缘带宽。也就是说,市场上有25Gb / s NRZ USR PHY,目前有多家供应商正在开发50Gb / s NRZ USR PHY。

GW16-500 Quad Glasswing Phy是首批利用和弦信号的PHY,这是一种创新的PHY技术。Glasswing使用CNRZ-5 和弦信号,这是一种信号形式,适合单端和差分信号之间的空间。和弦信令可以通过以更低的功耗和更少的pin获得更多的比特,从而使几乎每个接口都变得更好。

Glasswing FemtoSerDes PHY采用CNRZ-5(基于弦向信号的非归零5通道)调制技术,在6根电线上携带5比特。它具有出色的信号完整性(SI)属性,因为它结合了专门针对SI设计的特定多弦编码器和特定和弦接收器。良好的SI使Glasswing能够以最小的均衡在低信号摆幅下运行,从而节省了功率,而差分信号却没有2倍的线损。

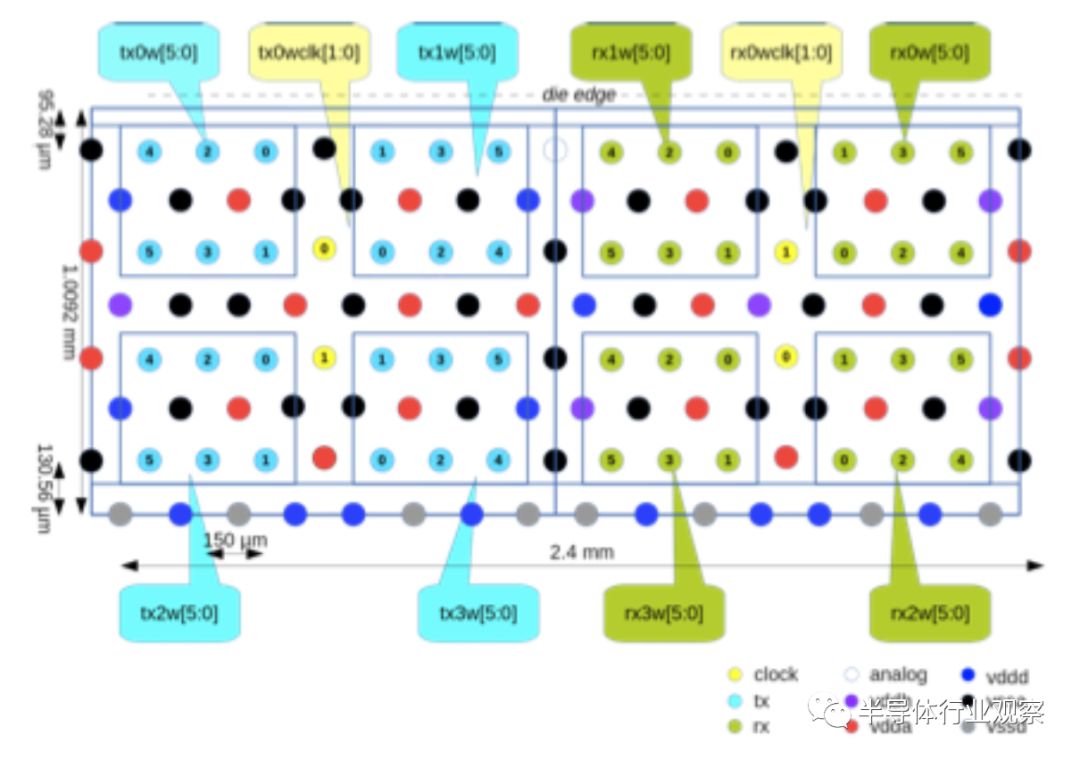

GW16-500 Glasswing PHY提供4套5个25Gb/s通道,通过24根数据线提供总计500Gb/s的带宽,每个方向提供2根时钟线。对系统来说,它看起来像20个共享一个时钟的25Gb/s服务器。PHY还通过使用时钟-数据校准(CDA)和转发时钟来节省功耗。下面的图8显示了Glasswing凹凸贴图,它只占据了2.4毫米的芯片边缘。

(3) AQlink chiplet USR证明点

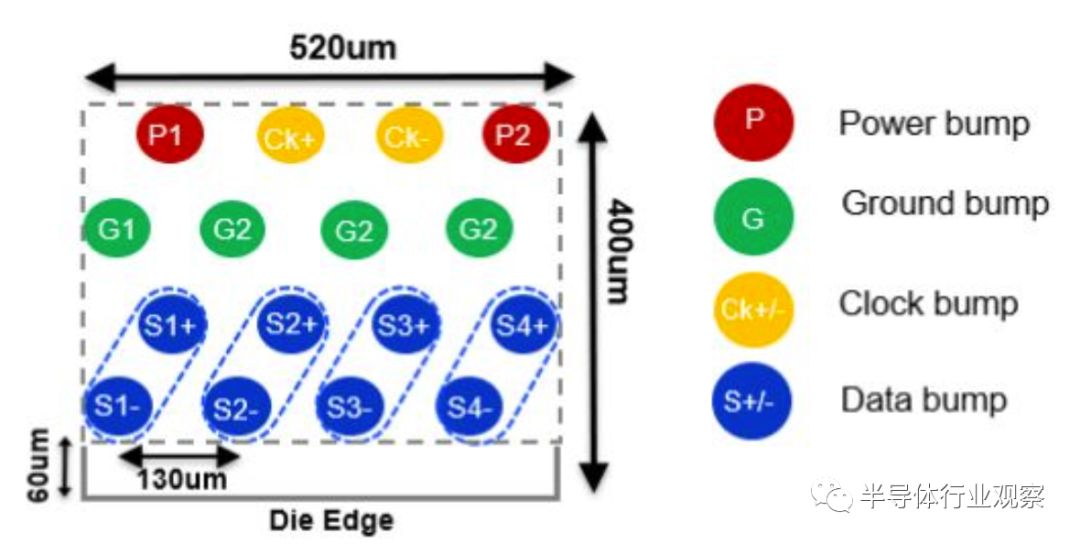

AQlink是由Aquantia公司开发的利用差分NRZ信号的USR PHY技术。最小的AQlink构建块是一个收发器,它包括两个用于收发接口的差分对和一个用于时钟接口的差分对。AQlink需要时钟转发的优点是简化了接收器中的数据恢复电路,因此有助于最小化接收器中的功率和面积。在时钟转发方案中,用于时钟发送器的时钟与发送数据信号一起转发给链路伙伴收发器。链路伙伴接收转发的时钟并重新生成与数据信号中心相位对齐的新时钟信号。为了限制时钟信号在封装基板上的凸点和轨迹的数量,每个差分时钟信号可以由多个收发器使用。这种拓扑的一个例子是AQlink-Quad1模块,如图9所示。AQlink-Quad1模块包括四个差分数据对和一个差分时钟。为了提高碰撞和跟踪效率,几个收发器可以共享一个差分时钟信号。然而,为了在数据速率为>50Gb/s时获得稳健的性能,建议最多与三个收发器(六个差分对)共享一个时钟信号。

图9:AQlink-Quad1有四个差分数据和一个差分时钟对的凹凸图

在14nm格芯工艺节点上首次实现了AQlink-Quad1。它支持每个端口20Gb/s- 56gb /s的吞吐量范围,或112Gb/s的发送和112Gb/s的接收,在典型的有机封装基板(例如GZ41基板材料)上,它在25mm的走线上支持每端口20Gb / s-56Gb / s的吞吐量范围,或总共112Gb / s的发送和112Gb / s的接收。通过以半速率运行PHY,可以将每个端口的数据速率降低到10Gb / s,其中每个位被复制两次并以连续的位时间进行传输。AQlink-Quad1在并行侧具有一个64位宽的接收器接口和一个64位宽的发送接口,其时钟频率最大为1.75GHz。可以向并行接口添加一个可选的2x适配器模块,以将接收和/或发送宽度增加到以最大875MHz时钟同步的128位。

AQlink-Quad1提供极具竞争力的能量效率,其本身是信号波特率、跟踪长度、电源电压和温度的函数。收发器在110C下,每端口56Gb/s,超过25mm的跟踪长度时,每比特消耗的能量最大。AQlink-Quad1硅已经集成在不同的IC产品中,已经充分验证了工艺、电压和温度(PVT),能够在不使用FEC的情况下提供BER<1E-15,并支持ESD为400V HBM和100V CDM。

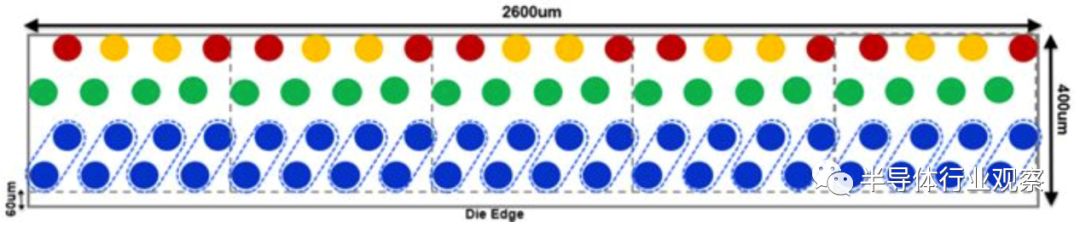

几个AQlink模块可以组合在一起,在裸片边缘构建更高吞吐量的数据接口。例如,AQlink Tera是通过将10个AQlink-Quad1模块组合在一起以提供高达1.12Tb/s的吞吐量来实现的。图10显示了AQlink-500G,它是通过将5个AQlink-Quad1模块组合在一起以提供高达560Gb/s的吞吐量创建的。AQlink-500G IP core 2占用1.04mm,0.4mm的高度超过2.6mm的芯片边缘。在它的并行侧,它有320位宽的接收接口和320位宽的发射接口。使用每个端口的32:64适配器,并行接口可以增加到640位宽的接收和640位宽的传输。

如上所述,为多芯片系统选择PHY协议有多种选择。如果不同的接口可以为更高数据传输层提供一个通用接口,则可以简化系统设计。PIPE接口一直是PCIe控制器和PHY之间的关键接口。PIPE的最初草案是由Intel在2002年定义的。自从PCIe演变以来,它已经进行了多次更新。

例如,定义CCIX协议时,其架构师会重用PCIe体系结构的各个部分,包括PIPE接口。市场上的某些或所有CCIX控制器实现都使用PIPE接口作为链接层和PHY层之间的链接。CCIX添加了一个附加的可选PHY波特率,但是此修改完全在PIPE上下文中完成。十六通道是PCIe和CCIX的高带宽实现的主要宽度。市场上重要的CCIX控制器仅支持16通道PIPE接口。

例如,可以使用PIPE适配器在Kandou Glasswing USR SerDes上承载16通道PIPE接口。该模块将CCIX IP控制器的PIPE接口连接到Glasswing。在启动时,使用自动启动机制将Glasswing的四个和弦中的每个和弦的五个32位子通道绑定在一起。这形成四个160位接口。自动启动将每个和弦的五个子通道对齐为单个160位链接。根据适配器的较长定义,将它们进一步划分为16个40位插槽。

每个插槽的最大容量为512/16 = 32Gb / s。来自PIPE接口的十位数据依次放入相应的插槽中。对于32GT / s(PCIe Gen 5),以25.6 GBaud运行Glasswing。对于25GT / s(CCIX ESM),Glasswing的运行速度为20 GBaud。对于16GT / s(PCIe Gen 4),以半速率模式在12.8 GBaud下运行Glasswing。

使用CCIX或PCIe控制器上PIPE接口的第4.2节(版本5.1)中的模式。Glasswing和PCIe / CCIX控制器必须在同一个传输时钟上计时。Glasswing的和适配器时钟发生器必须基于相同的来源。在缓冲中需要考虑所有组件的抖动和漂移。

PCIe和CCIX控制器都支持重传缓冲区,该缓冲区能够覆盖Glasswing的1E

-15

错误率所支持的任何错误。该错误率优于为PCIe / CCIX指定的错误率。

我们回顾了最近的结果,这些结果显示了在多芯片封装中显著降低成本的潜力。

通常,并行接口(例如高带宽存储器)所需的高导线密度要求使用硅中介层技术。如前所述,硅中间层比有机中间层要贵得多。商业供应商和学术研究人员均已证明,有机中间层可显著提高密度。凸点密度从150um增加到40-80um,导线密度从5um间隔增加,而不是典型的30um间隔。即,低成本有机衬底可以实现与使用高成本硅中介层所达到的密度相当的密度。

玻璃核技术(GCT)是硅中间层和有机衬底的一种高性能,高性价比的替代品。GCT充分利用了玻璃(优于硅)的优点,以允许使用直径较小的通孔和通孔之间的间距较小。GCT使用玻璃通孔(TGV)连接到再分配层(RDL),以在玻璃基板上创建所需的电路。玻璃的介电性能使其非常适合低损耗,超高速应用。这允许将IC直接放置在玻璃基板上,并使玻璃适用于高速度多芯片封装。

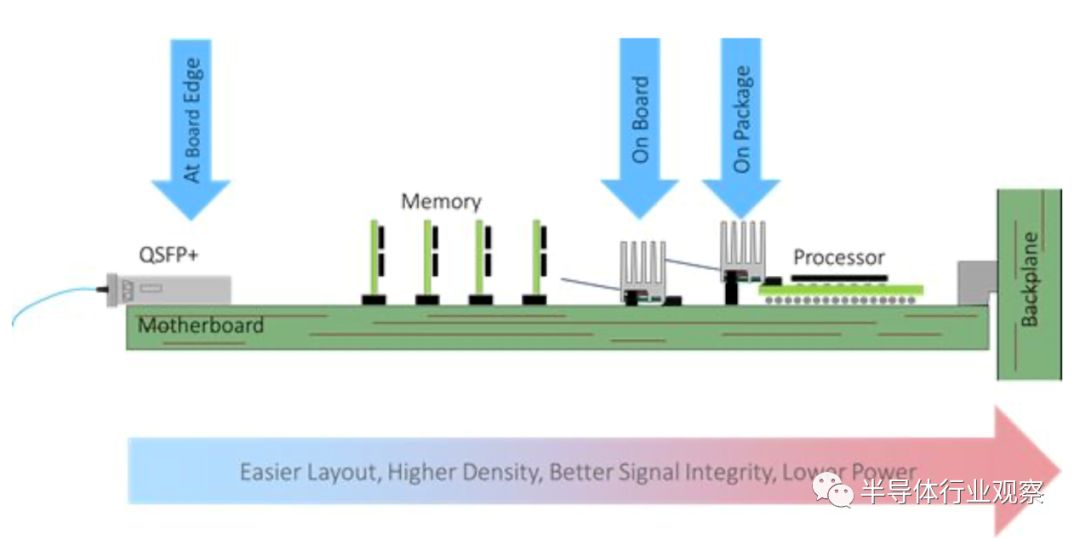

为了在不增加功耗的情况下增加封装I / O带宽,已经开发出了新的微型机载光学模块,可以将其放置在与IC封装非常接近的位置。Samtec的Firefly天桥系统与光学和微型同轴电缆模块兼容,就是这种解决方案的一个例子。当前,每个通道的速度为28Gb / s。

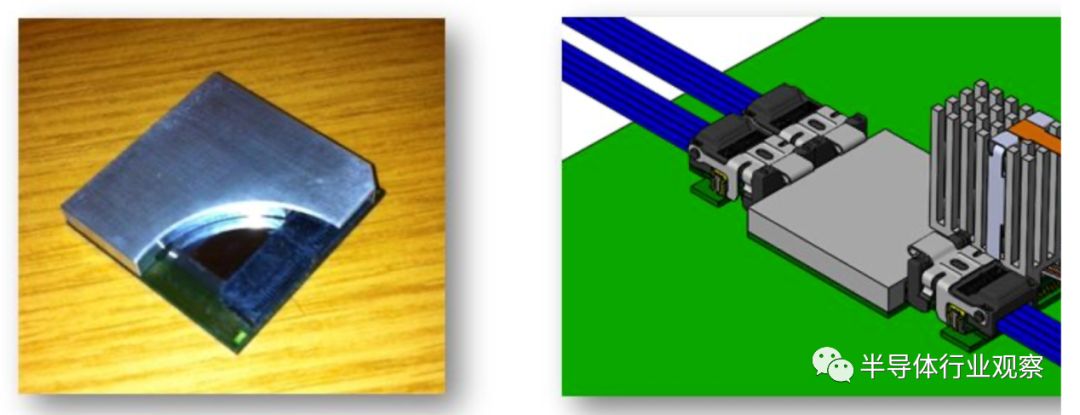

为了充分利用USR低功率SerDes所带来的速度提高和功率降低的优势,进一步的发展是将跨接式连接器直接置于封装的边缘。

Firefly连接器可以小到可以放在封装的边缘,如图14所示。

图14:两个Firefly连接器嵌入到一个45mm的方形封装中

此外,由于光模块是如此接近,因此可以省去光模块中的普通CDR中继器。目前正在开发56Gb / s的Firefly模块的直接连接版本(光学和电气版本均在下面显示)。

(4)指令驱动的开关结构(ISF):可伸缩的数据传输

通常,ASIC/SoC上对等元件之间的片上通信是同步的。用全芯片通信网络来实现这种同步通信所必需的深流水线会产生很大的面积和功率损失。ASIC的面积越大,同步片上通信的代价就越大。Netronome开发并使用了一种基于轻量级消息的片上数据通信协议。这允许使用一个简单的可伸缩的分布式交换结构来实现全芯片通信。

ISF互连是Netronome网络流处理器(NFP)中的主要全局总线。如下图15所示,NFP在物理上实现为逻辑块(或岛)的平铺数组。每个逻辑块通过一个简单的BoW接口与其直接的物理邻居连接。ISF上的数据传输是以编程方式编排的。ISF命令语法是可扩展的,支持用于数据传输的命令,甚至支持在另一个岛上的远程总线代理处进行处理,以便在数据所在的远程位置处理数据,从而最大限度地减少数据移动和处理时间。

在当前一代硅中,每个逻辑块最多可以有六个DSF接口(K=6)。1GHz下的每个64位宽DSF接口链路在节点处向每个逻辑块提供128Gb/s的双向带宽。因此,理论上每个逻辑块的总吞吐量是K*128Gb/s。在图15中的示例中,每个逻辑块可以支持768Gb/s的双向带宽。在由逻辑块组成的裸片(在典型的Netronome产品中)上访问数据的延迟在5到20纳秒之间变化。

分布式实现具有以下优点:

•

高带宽:

由于可以并行执行许多事务,因此可以实现与交叉开关相当的高聚合带宽, ISF对于每个岛都有单独的数据/命令路径和主数据。通过分布式仲裁,许多近邻连接可以同时运行。总线时钟频率可以更高,因为所有电线都是本地的。

•

高效节能:

由于几乎没有全局物理连接,因此ISF耗散的功率更少,并且时钟速度比全局总线快。

•

可扩展性:

ISF基础设施可跨多个不同的逻辑块实例进行扩展,支持每秒数十亿命令和万亿字节数据传输的峰值速率,使得这种分布式总线吞吐量可与crossbar相媲美。然而,这种物理分布的总线消耗更少的硅裸片面积。

我们建议将这种可扩展的设计扩展到多芯片封装中的片外数据通信。

八种商业模式

chiplet的愿景是一个广泛的生态系统,其中有成千上万个可互操作的chiplet构建在各个foundry中,这些chiplet可提供各种功能,以降低成本,加快产品上市时间并提高成本效益。业务模型将需要支持这一愿景。

为了使这种方法成功,需要建立新的商业模式。集成ASIC供应商已经为集成高带宽存储器(HBM)模块、存储器设备和已知的良好裸片(KGD)系统建立了有效的模型。这个模型可以扩展以提供与来自多个源的组件更复杂的集成。下面的插图概述了这样一种业务模型,其结构为各种组件的“所有者”。

chiplet模型也可以使总体投资成本受益。例如,如果一家公司在开发机器学习加速器方面具有真正的价值,那么他们为每个可能的系统开发网络接口可能就没有意义。能够通过选择可用的组件将网络接口引入设计中,从而减少了开发和构建网络接口硬件所需的投资。相反,构建这些网络接口chiplet的公司将从数量增加中受益,从而将其投资摊销到更大的收入流中。

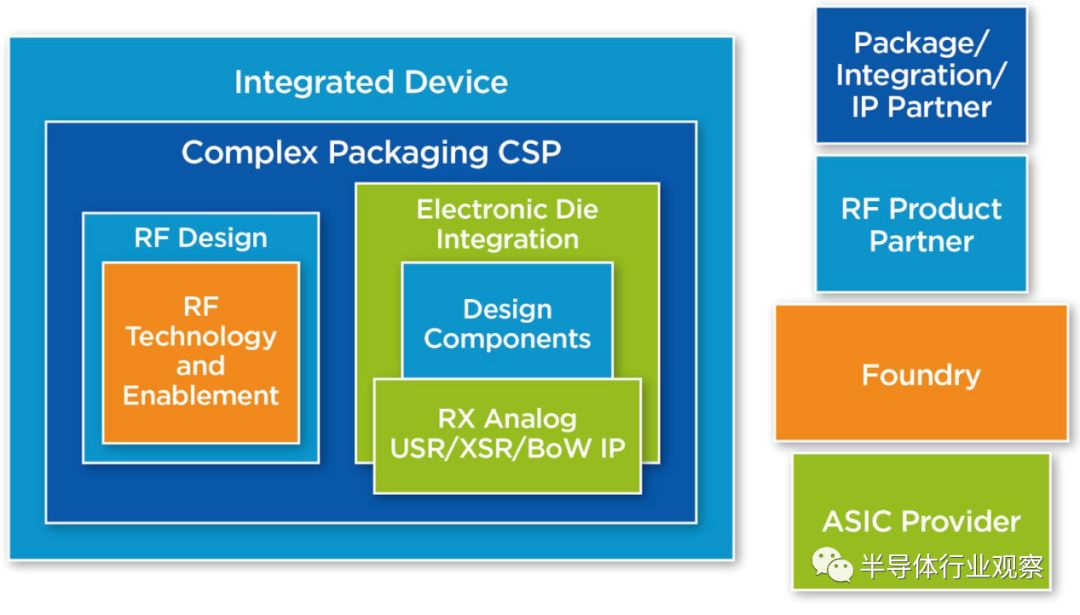

图16中的示例显示了构建组件的选项,其中RF设计公司可能需要在各个节点中集成额外的复杂逻辑功能和模拟IP。在这种情况下,射频设计公司利用与ASIC供应商的合作关系开发“产品”,将接口IP和功能构建到产品的一部分。

图16:带有片间接口标准IP的新型射频元件设计流程

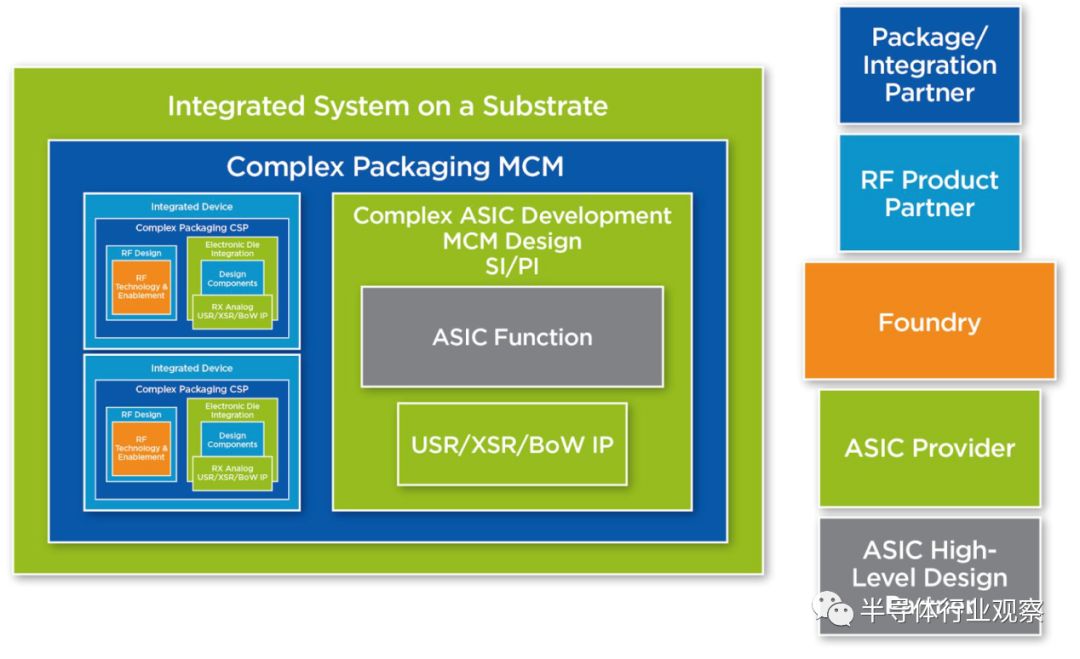

下一阶段的组装如下图所示,其中ASIC提供商与外包半导体组装和测试公司(OSAT)合作,使用从以上RF提供商委托的组件以及OEM客户ASIC功能来设计和组装MCM封装。

当然,这些复杂的模型需要建立细节,以便能够顺利地解决采购和测试需求的定价问题,但是随着行业在模块中提供越来越复杂的组件,其中许多路径正变得越来越熟悉。

多供应商裸片生态系统的一个结构性问题是以晶圆形式交付KGD的实践。传统的方法包括用墨水点(或在数据库中做一个条目)标记测试失败的裸片,然后交付标记的晶圆。然后将标记的晶圆切成小块并封装。

在多供应商生态系统中使用此流程的一个问题是,它将每个晶圆的良率暴露给裸片的客户。对于半导体制造商来说,芯片良率往往是一个受到严密保护的事实。

在实现多供应商生态系统时,

至少有三种解决方案可供使用:

这些解决方案中的每一个都解决了良率风险的问题。这些解决方案提供了不同的方法来交付已知良好的设备以进行集成。

在过去的十年里,片上系统(SoC)已经成为除大型数据中心服务器外提供计算能力的主要方式。PC、笔记本电脑、手机、网络网关和各种各样的嵌入式系统都采用了SoC。SoC通常由称为硅IP的各种预先设计的逻辑块组成。

传统上,硅IP的许可方通过预付许可费和单位使用费的组合来提供他们的技术。他们将提供验证测试,并预计与设计错误相关的责任限额。一个IP供应商将寻求在多个客户之间分摊IP开发的成本,这要比SoC供应商自己开发功能并且是该功能的唯一用户所能获得的价格低。

互连IP有一个独特的要求,即同一IP必须在链路的两侧工作。系统架构师和采购经理将坚持认为,IP具有灵活性,可以移植到不同的foundry,移植具有成本效益,最终互连IP可以从多个IP供应商处获得,或者可以由芯片供应商独立开发。业务模型将要求互连IP贡献在整个chiplet组生态系统中可用和可访问。这可以通过现有的标准组织(如OIF或IEEE)、现有的行业联盟(如开放计算平台(OCP))或新的联盟(如USR联盟)来实现。

chiplet集成将需要不同于硅IP的业务模型。其原因是,与硅IP不同,chiplet将需要被加工制造且质量保证长达数年甚至数十年。

大型半导体公司可能会继续垂直整合其设计,构建,组装和测试自己的基于chiplet的MCM解决方案的能力。设计面向特定任务的chiplet的较小公司将不太可能具有此功能,而是依靠foundry或封装厂在MCM中进行集成和测试。

chiplet公司需要根据foundry愿意提供的支持,就chiplet的使用寿命向客户提供制造保证。或者,为了更好地保证对终端客户的供应,chiplet供应商可以向多芯片模块开发商提供制造权转让,以换取版税。

最初,foundry和/或封装厂不仅要代表chiplet开发商承担制造chiplet的责任,而且还要承担为MCM集成商提供合格的chiplet的责任,然后提供许可或使用费的运营业务根据最终单位的销售情况返回给chiplet供应商。foundry或封装厂将建立一个chiplet设备目录,可以选择将其集成到MCM中。

随着时间的推移,随着不同chiplet库存的扩大,系统公司将希望灵活地混合和匹配来自不同foundry的chiplet。很容易想象,新公司可能会形成新的基于芯片的MCM解决方案,并利用整个行业的最佳解决方案。

大型半导体公司的半导体厂商可能会采用一种为自己的设备开发chiplet技术的模式,在这种技术中,他们有75%到80%的技术是由芯片供应商提供的,而只有在非战略性或没有经济意义的情况下,才会外包特定的技术。可以作为外包芯片开发候选技术的例子包括:内存技术、SerDes技术、FPGA技术和DSA技术。然后,大型半导体厂商可以建立自己的封装、互连技术和chiplet厂商的专属生态系统。

chiplet设计类似于当前SoC设计但是价格可能会小于完全集成的SoC设备。因为它们是在硅中实现的,所以它们需要对已知的良好的裸片进行测试和最终封装的封装内测试开发对应的测试程序。必须为重新设计做好准备,并并需要建立机制以便在最终产品生命周期内跟踪硅的修订。

四、开放的加速器和chiplet将驱动新的工作方式

一种方法是将MCM视为一种新的PCB,在这种PCB中,组装、测试和部署可靠的多芯片解决方案需要一个可互操作的组件、互连、协议和软件的生态系统。

MCM并不是什么新鲜事物,并且可以轻松利用现有的许多半导体生态系统进行硅设计,KGD测试,封装设计和组装。商业模式通常无需更改。但是,当MCM包含许多chiplet时,将需要额外的注意和规格,例如:

由Netronome、Achronix、GlobalFoundries、Kandou、NXP、Sarcina和SiFive联合发起的ODSA工作组已经成立,旨在开发一种开放式架构和相关规范,用于开发承诺降低硅开发和制造成本的chiplet。ODSA工作组还将开始研究可行商业模式的细节,以实现chiplet的愿景。

结论

为了弥补摩尔定律的终结,需要DSA来处理数据中心和网络边缘的工作负载。然而,目前为DSA开发定制单片ASIC的方法在经济上已不可行。异构系统中,集成ASIC由来自多个工艺节点和/或多个供应商的chiplet组成,是降低开发成本的一种选择。目前开发完整系统的方法是封闭和专有的。

最近调查的互连和封装技术以及数据传输协议方面的进展显著改善了异构系统。这些进步被用于为DSA提出一种新的开放架构ODSA。与当前的标准化方法不同,ODSA提出了实现DSA所需的完整堆栈的标准,包括数据传输协议。该提案是建立ODSA的原型实现。还审查了如何发展商务模式以支持基于chiplet的制造流程。

ODSA体系结构的主要优点之一是能够将PHY接口与用于其他处理功能的物理裸片解耦。在chiplet之间使用的事务层是实现这种集成的关键因素。通过利用ODSA模型,开发人员可以根据性能需求、IP可用性和成本自由地为每个chiplet选择最佳解决方案。开发人员可以快速地将支持ODSA的chiplet组装成最好的加速器。

本文摘译自ODSA工作组,由半导体行业观察翻译,电子科技大学黄乐天副教授参与校正,特此感谢!

*免责声明:

本文由作者原创。

文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2240期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

“芯”系疫情

|ISSCC 2020

|日韩芯片

|华为

|

存储

|

氮化镓|高通|康佳

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!