来源:内容由半导体行业观察(ID:icbank)编译自「groq」,谢谢。

运行 Batch Size 为1(即在推理处理期间对单个图像或样本进行计算)对于许多机器学习工作流来说是一个有价值的选择—特别是那些需要实时响应的工作流。对于安全性至关重要的应用以及通过视觉对象检测,语音识别或其他形式的数据输入创建新的客户体验而言,近乎瞬时的推断至关重要。例如,在电子商务网站中,当零售客户说出或键入产品名称时自动填充建议的能力就是最佳响应性需要batch size大小为1的一个例子。在无人驾驶汽车中,导航系统可能需要在几毫秒内做出反应,以避免撞上障碍物,因此拥有一个确保每次都能保证最小响应时间的处理体系结构对于安全是至关重要的。然而,小batch size和batch size大小1为机器学习应用程序引入了大量的性能和响应复杂性,特别是在基于GPU的传统推理平台上。

GPU过去是为大规模并行处理而设计的,它建立在多数据或多任务、固定结构的处理引擎上。这些平台最初是为游戏应用程序的实时三维图形渲染而创建的。

GPU基于一组并行进程来渲染图形,这些并行进程同时发生在数百或数千个内核中。

并行性依赖于管道架构,每个处理阶段都向正在进行的并行计算添加新数据。

由于这种管道架构,GPU每秒可以执行数十亿个与图形相关的几何计算。

在机器学习应用程序中作为处理单元使用时,当以小batch size的数据输入时,GPU的性能会显著下降,因为数据流中的间隙会导致GPU执行的停滞。这种延迟可能会对batch size大小为1的实时推断性能产生显著影响,并对机器学习平台投资的TCO(总拥有成本)产生相关影响。如果应用程序依赖于batch size大小为1的处理来实现实时响应—例如,对于快速响应时间非常重要的应用程序—基于GPU的平台可能无法提供足够快的推断性能。这里将响应能力定义为在最小执行时间(延迟)内为工作负载提供服务的能力。

Groq为机器学习提供了一个替代平台,它不依赖于GPU并行性和长延迟的性能限制,为机器学习工程师提供了一个卓越的推理平台,对小batch size或任何规模的工作负载都没有性能损失。Groq的Tensor流处理器(TSP)架构是专门为机器学习和其他计算密集型应用程序的性能要求而设计的,要求低延迟和高吞吐量。

一个机器学习平台,即使在batch size为1的情况下也具有最高的性能

值得注意的是,Groq架构高度关注batch size大小为1时的低延迟、单线程性能。

这个架构在我们的Tensor流处理器(TSP)中实现,是一个单线程、单核架构,可以在任何batch size下提供最大的性能。

batch size为1时,Groq的处理器要比基于GPU的平台快17.6倍,大batch size时则要快2.5倍。

Groq编译器在TSP上调度程序执行,为在不受传统GPU体系结构的限制和通信开销的情况下实现灵活性和大规模并行性提供了新的范例。Groq编译器将流操作数编排为在芯片上执行的运算符。因为它了解硬件和每条指令的速度,所以编译器可以准确地告诉硬件效率该做什么以及什么时候做。这允许确定性、可重复性和可预测的性能。指令流到硬件完全由编译器编排,使处理高效且可预测。这种性能的可预测性非常有价值,特别是对于安全关键型应用程序来说,实时响应是至关重要的。

实现推理敏捷性(响应能力和性能的结合)的困难,在我们比较一些领先的机器学习平台的已发布基准的性能指标时变得更加明显。

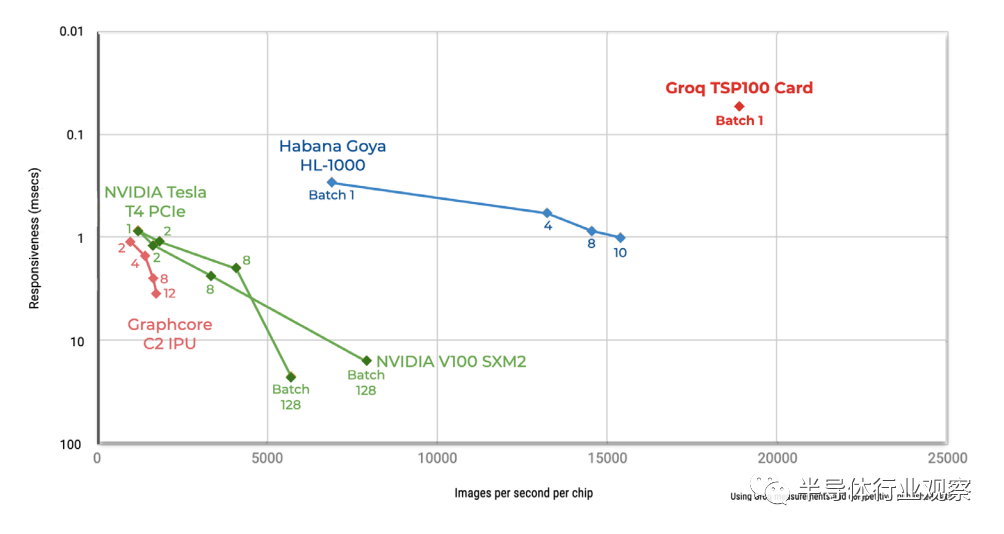

下页的图1说明了在处理小batch size工作负载时,用于领先推理平台的ResNet-50v1.5基准的图像识别性能度量。该图显示推理平台处理小batch size图像数据所需的时间,X轴表示每个芯片每秒的图像,Y轴表示以毫秒为单位的延迟。这些基于GPU的推断平台都会随着batch size大小的增加呈下降趋势,并向右移动,这意味着更大的延迟和更低的响应性。领先的基于GPU的推断解决方案NVIDIA V100,batch size大小为1,每秒可以处理1000多个图像,延迟为1毫秒。在batch size大小为1并运行ResNet-50 v2时,Groq TSP100芯片每秒能够处理18900个图像,延迟小于0.1毫秒。这种级别的性能是可能的,因为使用Groq,不需要运行更大的batch size大小来实现高吞吐量。在小batch size情况下,Groq芯片的性能比运行ResNet-50v1.5基准的基于GPU的平台高出3到20倍。

不同平台之间的性能差异如图2所示;它们以增加延迟(y轴上的响应速度较低)为代价交换更多的吞吐量(x轴上的每秒推断)。图2显示了在运行基准ResNet-50工作负载时低延迟需求或响应性对四个主要推断平台的性能的影响。x轴的范围从0到100%,表示必须以亚毫秒级延迟处理的总工作负载的百分比,尽可能接近实时。y轴表示以每秒推理次数(IPS)衡量的实际推理性能。

在图中,Groq TSP100推理平台的性能并没有随着响应速度的增加而降低:无论以零响应速度运行还是以100%响应速度运行,Groq平台都以最佳性能运行。但是,随着低延迟、响应性工作负载百分比的增加,基于NVIDIA V100和NVIDIA T4 GPU的平台性能迅速下降。在使用基于GPU的推理解决方案时,即使只有很小比例的低延迟,实时工作负载也会将宝贵的资源滞留在集群中,从而降低集群的利用率和总体性能。

当处理低延迟工作负载时,性能的急剧下降会影响执行实际推理处理所需的机器学习集群的大小。无论有多少推理工作量响应,Groq平台都能支持近20,000 IPS。然而,这两个NVIDIA平台不仅一开始的峰值性能IPS数量较少,而且一旦将任何实时响应工作负载添加到工作流中,IPS就会逐渐减少。如果运行一个100%的推理平台,延迟小于1毫秒,Groq芯片的速度几乎比NVIDIA GPU快18倍。

当将上述结果外推到购买用于计算集群设计的参数时,这种性能和延迟差异变得特别有意义。为了实现少量Groq处理器的推理处理性能,需要在大量的NVIDIA GPU上进行投资。

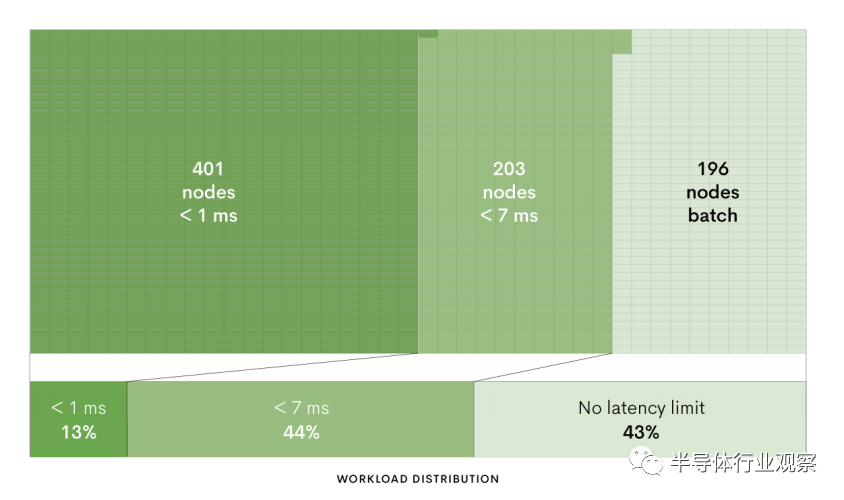

例如,一个数据中心工程师正在部署一个800节点的计算集群来进行图像分类,该集群的一部分工作负载分布需要高度响应的处理,而其他工作负载的需求较少。图3演示了一个构建在NVIDIA V100 GPU上的800节点集群,它是为ResNet-50推理而设计的。作为节点性能要求的一部分,13%的工作负载必须具有高响应性,延迟小于1毫秒;另外44%的工作负载分布要求响应时间小于7毫秒;43%没有延迟要求,可以以batch size速度运行。由于小batch size时GPU的性能较低,要保证13%的工作负载在高响应推理下运行,需要将整个集群(401个节点)的一半以上用于处理低延迟工作负载。

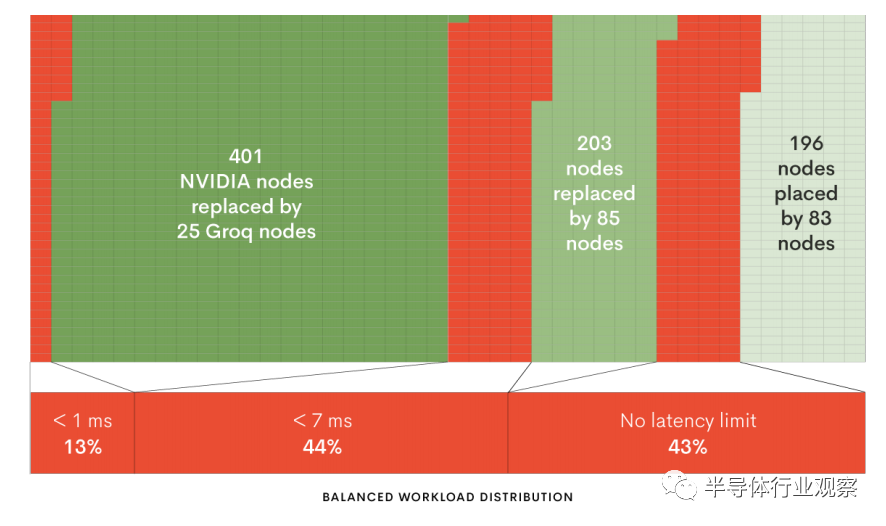

由于在基于Groq的平台上能够更高效地处理小batch size工作负载,因此在Groq芯片上实现相同的延迟要求和工作负载分布所需的节点数要少得多;参见下面的图4。13%的工作负载必须是高响应的,延迟小于1毫秒,只能由25个基于Groq的服务器处理;需要响应时间小于7毫秒的工作负载分布的44%可以由85个Groq节点处理;可以batch size速度运行的43%的工作负载可以由83个Groq节点处理。总的来说,在相同的ResNet-50图像分类工作负载下部署基于Groq的节点会导致集群服务器减少75%,同时保持相同的吞吐量,这是由于NVIDIA V100 GPU和Groq处理器之间的总体性能差异16倍造成的。

事实上,在集群中部署了Groq之后,就不需要区分性能和响应能力,因为Groq处理batch size大小为1和大批大小的batch size时具有相同的低延迟和高效率。因此,对于需要响应能力以满足用户期望和满足严格的服务水平协议(sla)的工作负载,只需要25台Groq服务器就可以替代401台NVIDIA服务器。

机器学习推理的性能和响应能力之间的比率对于计算集群的设计和投资具有显著的现实影响。其他机器学习平台需要在延迟和吞吐量之间进行权衡。在非Groq平台中,性能会迅速下降,即使一小部分工作负载需要实时、低延迟响应。Groq革命性的TSP架构提供业界领先的性能和亚毫秒级延迟,为计算密集型应用程序提供高效的软件驱动解决方案。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2307期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

政策|海思

|集成电路

|

AI

|CMOS

|晶圆|ARM|射频|台积电

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!