来源:内容

编译自

「

9to5google

」,谢谢。

自Pixel 2以来,Google一直在其智能手机中包含自己的配套芯片组,以改善摄影和其他功能。不过,随着Google确认其最新的旗舰智能手机Pixel 5中放弃了Neural Core,谷歌似乎已经结束了这一趋势。

Pixel Neural Core是Pixel Visual Core的后继产品。两种芯片组均由Google制造,旨在改善摄影效果。特别是在神经核心上,谷歌还使用该芯片来加快面部劫夺,谷歌助手和Pixel 4上的其他新功能。

不过,谷歌的Pixel“ a”系列基本上证实了确实不需要添加芯片。Pixel 3a和4a在拍摄和处理速度方面都与Pixel 3和Pixel 4差不多,但是令人惊讶的是,Pixel 5的规格列表中缺少了自制芯片组。

谷歌在接受Android Police采访时证实,Pixel 5和Pixel 4a 5G都缺乏神经核心。谷歌还提到,通过优化,Pixel 5的Snapdragon 765G能够保持与Pixel 4“相似”的相机性能。

两款新手机都没有Pixel Neural Core,也没有面部解锁功能。

这是否意味着Pixel Neural Core永远消失了?可能不是。谷歌已经提到它将在未来的硬件中恢复Soli,因此可以肯定的是,神经核心也将最终回归。不过,值得注意的是,两款新Pixel仍提供Titan M芯片以确保安全性。

延伸阅读:谷歌手机上的这颗芯片或将改变手机摄影行业

谷歌的上一代手机Pixel 3被誉为最佳拍照手机是有原因的。因为Google在上面使用了其HDR +软件包中的软件算法来处理像素,当当这些与一点机器学习结合使用时,一些非常壮观的照片可能来自具有标准配置硬件的手机。

为了帮助处理这些算法,谷歌使用了一种被称为Pixel Visual Core的专用处理器,这是我们于2017年首次在Pixel 2上看到的芯片。今年看来,谷歌似乎已经用一种称为Pixel Neural Core的东西代替了Pixel VIsual Core。

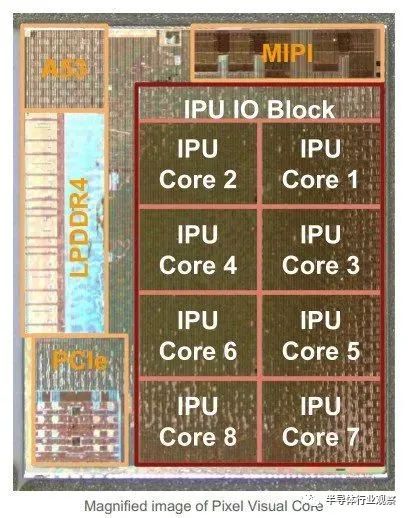

据知乎用户Chenjie Luo介绍,Pixel 1的HDR+是在高通的HVX加速器上跑的,因为HVX不是针对图像处理设计,所以速度很慢。为了达到快速连拍的用户体验,google camera做了一个图像缓存,把camera sensor的每一帧都存在内存里,排队处理HDR。这样一代的Pixel用户就不会察觉HDR处理的时间。但是这种处理方式带来了一个问题:像Instagram这样的第三方拍照共享的app需要所拍即所得,用户是不能等好几秒HDR做完了再p图分享的。所以在一代上,HDR+是google camera app独有的功能,不能用在第三方app上。由于这个原因以及老板的满腔热血,就催生了Pixel Visual Core来硬件加速HDR+,这样第三方的app就可以瞬间完成HDR+计算得到处理后的照片。实测效果惊艳,特别是在高光照对比下前后景都非常清晰,不会出现脸部过暗的照片。这个芯片牛逼的地方就在于8个IPU core是可以编程的,不完全是一个ASIC,所以有很多其他的应用场景。当时设计这个芯片的初衷就是做个全能的图像处理芯片,HDR+是第一个showcase。

最初的Pixel Visual Core旨在加速Google的HDR +图像处理使用的算法,这就使得Pixel 2和Pixel 3拍摄的照片看起来很棒。它使用了一些机器学习程序和所谓的计算摄影来智能地填充不太完美的照片部分。而实际上效果也真的很好;它允许带有现成相机传感器的手机拍摄的照片质量更优。

如果我们相信Pixel Neural Core,那么Pixel 4将再一次争夺智能手机摄影领域的头把交椅。

看来Google正在使用以神经网络技术为模型的芯片,以改善其2019年Pixel手部的图像处理能力。神经网络是您可能会听到不止一两次的内容,但该概念并不经常被解释。相反,它看起来像是一些类似于魔术的Google级计算机。事实并非如此,而神经网络背后的想法实际上很容易使您的头脑很容易混乱。

神经网络是根据人类大脑建模的算法组。它“效仿”的并不是大脑的外观甚至工作原理,而是大脑如何处理信息的方法。神经网络通过所谓的机器感知(通过机器传感器等外部传感器收集和传输的数据)获取感官数据,并识别。

这些数据是称为向量的数字。来自“真实”世界的所有外部数据(包括图像,声音和文本)都被转换为矢量,并被分类和分类为数据集。我们可以将神经网络视为存储在计算机或电话上的事物之上的额外层,该层包含有关其含义的数据——它的外观,听起来像什么,它说什么以及何时发生。建立目录后,可以对新数据进行分类并与之进行比较。

一个真实的例子可以使这一切解析得更清楚。NVIDIA生产的处理器非常擅长运行神经网络。该公司花费了大量时间将猫的照片扫描并复制到网络中,一旦完成,通过神经网络的计算机集群就可以在其中包含猫的任何照片中识别出猫。小型猫,大型猫,白色猫,印花布猫,甚至山狮或老虎都是猫,这主要是因为神经网络拥有关于猫“是”什么的大量数据。

考虑到该示例,我们不难理解Google为什么要在手机内部利用这种功能。这些能够与大量数据链接的神经核心将能够识别相机镜头所看到的内容,然后决定要做什么。也许有关其所见和所期望的数据可以传递给图像处理算法。或者,可以将相同的数据输入给Assistant来识别毛衣或苹果。或者,也许您可以比Google现在更快,更准确地翻译书面文本。

毫不费吹灰之力地认为Google可以设计一种可以与神经网络和电话内的图像处理器接口的小型芯片,并且很容易理解为什么要这样做。我们不确定确切地说是Pixel Neural Core是什么,或者可能用于什么用途,但是一旦“正式”发布时,一旦看到手机及其实际细节,我们肯定会知道更多。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2450期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

晶圆|IP

|

SiC|并购|射频|台积电|Nvidia|苹果

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!